ąÆ čĆčāą▒čĆąĖą║čā "ąĀąĄčłąĄąĮąĖčÅ ąŠą┐ąĄčĆą░č鹊čĆčüą║ąŠą│ąŠ ą║ą╗ą░čüčüą░" | ąÜ čüą┐ąĖčüą║čā čĆčāą▒čĆąĖą║ | ąÜ čüą┐ąĖčüą║čā ą░ą▓č鹊čĆąŠą▓ | ąÜ čüą┐ąĖčüą║čā ą┐čāą▒ą╗ąĖą║ą░čåąĖą╣

ąÆ čĆą░ą▒ąŠč鹥 ąŠą▒čüčāąČą┤ą░ąĄčéčüčÅ ąĖą┤ąĄčÅ ą┐čĆąĖą╝ąĄąĮąĄąĮąĖčÅ ą╝ąĄč鹊ą┤ą░ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ ą┤ą╗čÅ ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░ ą▓ čĆąĄą░ą╗čīąĮąŠą╝ ą▓čĆąĄą╝ąĄąĮąĖ ąĮą░ą┤ ą┐čĆąŠč鹊ą║ąŠą╗ąŠą╝ HTTP. ąÜą╗ąĖąĄąĮčé ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ąĮąĄą┐čĆąĄčĆčŗą▓ąĮčāčÄ ąĘą░ą│čĆčāąĘą║čā ąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ ą┐ąŠč鹊ą║ą░ ą║ą░ą║ ąĄą┤ąĖąĮąŠą│ąŠ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, čüąŠąĘą┤ą░ą▓ą░ąĄą╝ąŠą│ąŠ ąĖčüč鹊čćąĮąĖą║ąŠą╝ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą┐ąŠ ą╝ąĄčĆąĄ ąĄąĄ ą┐čĆąŠčģąŠąČą┤ąĄąĮąĖčÅ. ą×ą▒čüčāąČą┤ąĄąĮą░ ą▓ąŠąĘą╝ąŠąČąĮą░čÅ čĆąĄą░ą╗ąĖąĘą░čåąĖčÅ ą┐čĆąŠč鹊čéąĖą┐ą░ čüąĖčüč鹥ą╝čŗ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąĄą┤ąĖą░ ą▓ čĆąĄą░ą╗čīąĮąŠą╝ ą▓čĆąĄą╝ąĄąĮąĖ ąĮą░ ąŠčüąĮąŠą▓ąĄ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ą╝ąĄč鹊ą┤ą░ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ.

An idea of progressive download adaptation for real time media streaming over HTTP was discussed. The client is to download a continuous stream as a single media file created while the translation passes. On the basis of this method a possible implementation of real time media streaming has been proposed.

ąśą│ąŠčĆčī

ąśą│ąŠčĆčī ąÆą╗ą░ą┤ąĖčüą╗ą░ą▓

ąÆą╗ą░ą┤ąĖčüą╗ą░ą▓ąÆ ą┐ąŠčüą╗ąĄą┤ąĮąĄąĄ ą▓čĆąĄą╝čÅ ąĮą░ą▒ą╗čÄą┤ą░ąĄčéčüčÅ ą▒čāčĆąĮąŠąĄ čĆą░ąĘą▓ąĖčéąĖąĄ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ ą┐ąŠč鹊ą║ąŠą▓ąŠą│ąŠ ą▓ąĄčēą░ąĮąĖčÅ ą▓ čĆąĄą░ą╗čīąĮąŠą╝ ą▓čĆąĄą╝ąĄąĮąĖ ąĮą░ą┤ ą┐čĆąŠč鹊ą║ąŠą╗ąŠą╝ HTTP [1]. ąÆ ą║ą░č湥čüčéą▓ąĄ ą╝ą░čüčüąŠą▓ąŠą│ąŠ ąĖ čāą┤ąŠą▒ąĮąŠą│ąŠ ąĖąĮčüčéčĆčāą╝ąĄąĮčéą░ ą┐čĆąŠčüą╝ąŠčéčĆą░ čéčĆą░ąĮčüą╗čÅčåąĖą╣ čłąĖčĆąŠą║ąŠ ąĖčüą┐ąŠą╗čīąĘčāčÄčéčüčÅ Web-ą▒čĆą░čāąĘąĄčĆčŗ. ąĪčāčēąĄčüčéą▓čāąĄčé ąĮąĄčüą║ąŠą╗čīą║ąŠ ą▓ąĄą┤čāčēąĖčģ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ ąČąĖą▓ąŠą│ąŠ ą▓ąĄčēą░ąĮąĖčÅ, ąŠčüąĮąŠą▓ą░ąĮąĮčŗčģ ąĮą░ ą┐čĆąŠč鹊ą║ąŠą╗ąĄ HTTP. ąØą░ąĖą▒ąŠą╗ąĄąĄ ą┐ąŠą┐čāą╗čÅčĆąĮčŗą╝ąĖ ąĖąĘ ąĮąĖčģ čÅą▓ą╗čÅčÄčéčüčÅ Apple HTTP Live Streaming (HLS) [2], Adobe HTTP Dynamic Streaming (HDS) [3], Microsoft Smooth Streaming (SS) [4], MPEG-DASH [5]. ą×čéą╗ąĖčćąĖč鹥ą╗čīąĮąŠą╣ ąŠčüąŠą▒ąĄąĮąĮąŠčüčéčīčÄ čŹčéąĖčģ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ čÅą▓ą╗čÅąĄčéčüčÅ č鹊, čćč鹊 ą║ą╗ąĖąĄąĮčé ą┐ąŠą╗čāčćą░ąĄčé čéčĆą░ąĮčüą╗čÅčåąĖčÄ ą┐čāč鹥ą╝ ąĘą░ą│čĆčāąĘą║ąĖ čü čüąĄčĆą▓ąĄčĆą░ ąĮąĄą▒ąŠą╗čīčłąĖčģ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓ ą┤ą╗ąĖč鹥ą╗čīąĮąŠčüčéčīčÄ ąĮąĄčüą║ąŠą╗čīą║ąŠ čüąĄą║čāąĮą┤. ąöą╗čÅ č鹊ą│ąŠ čćč鹊ą▒čŗ ą║ą╗ąĖąĄąĮčé čüą╝ąŠą│ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčī čäčĆą░ą│ą╝ąĄąĮčéčŗ ą▓ ąĮčāąČąĮąŠąĄ ą▓čĆąĄą╝čÅ ąĖ ą▓ ą┐čĆą░ą▓ąĖą╗čīąĮąŠą╣ ą┐ąŠčüą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīąĮąŠčüčéąĖ, čüąĄčĆą▓ąĄčĆ ą┐ąŠą┤ą│ąŠčéą░ą▓ą╗ąĖą▓ą░ąĄčé ą┤ą╗čÅ ą║ą╗ąĖąĄąĮčéą░ čüą┐ąĄčåąĖą░ą╗čīąĮčŗą╣ čäą░ą╣ą╗ ŌĆō ą┐ą╗ąĄą╣-ą╗ąĖčüčé ("ą╝ą░ąĮąĖč乥čüčé"), ą▓ ą║ąŠč鹊čĆąŠą╝ čüąŠą┤ąĄčƹȹĖčéčüčÅ čüčģąĄą╝ą░ ą┐čĆą░ą▓ąĖą╗čīąĮąŠą│ąŠ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓, ą░ čéą░ą║ąČąĄ čüąŠą┤ąĄčƹȹ░čéčüčÅ ą┐ą░čĆą░ą╝ąĄčéčĆčŗ, ąĮąĄąŠą▒čģąŠą┤ąĖą╝čŗąĄ ą┤ą╗čÅ ąĮą░čćą░ą╗ą░ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ. ą¤ąŠ ą╝ąĄčĆąĄ ą┐čĆąŠčģąŠąČą┤ąĄąĮąĖčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą║ą╗ąĖąĄąĮčé ą┤ąŠą╗ąČąĄąĮ ą┐ąĄčĆąĖąŠą┤ąĖč湥čüą║ąĖ ąŠą▒ąĮąŠą▓ą╗čÅčéčī čüąŠą┤ąĄčƹȹĖą╝ąŠąĄ ą┐ą╗ąĄą╣-ą╗ąĖčüčéą░ ąĖ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčī ąĘą░ą│čĆčāąĘą║čā čäčĆą░ą│ą╝ąĄąĮč鹊ą▓ ąĖ ąĖčģ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ ą▓ čüąŠąŠčéą▓ąĄčéčüčéą▓ąĖąĖ čü č鹥ą╝, ą║ą░ą║ čŹč鹊 ą┐čĆąĄą┤ą┐ąĖčüą░ąĮąŠ ą▓ ą╝ą░ąĮąĖč乥čüč鹥.

ąÆąŠąĘą╝ąŠąČąĮčŗ čĆą░ąĘąĮčŗąĄ čüčģąĄą╝čŗ ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓ ąĮą░ čüąĄčĆą▓ąĄčĆąĄ. ąÆ ąŠą┤ąĮąŠą╝ čüą╗čāčćą░ąĄ čäčĆą░ą│ą╝ąĄąĮčéčŗ čüąŠąĘą┤ą░čÄčéčüčÅ ą┐ąŠ čģąŠą┤čā čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą▓ ą▓ąĖą┤ąĄ ąĮąĄą▒ąŠą╗čīčłąĖčģ čäą░ą╣ą╗ąŠą▓ ąĖ ą┐čĆčÅą╝ąŠ ą▓čŗą║ą╗ą░ą┤čŗą▓ą░čÄčéčüčÅ ąĮą░ HTTP-čüąĄčĆą▓ąĄčĆąĄ. ąÆ ą┤čĆčāą│ąŠą╝ čüą╗čāčćą░ąĄ čüąĄčĆą▓ąĄčĆ ą▓ ąŠčéą▓ąĄčé ąĮą░ ąĘą░ą┐čĆąŠčüčŗ ą║ą╗ąĖąĄąĮčéą░ čüąŠąĘą┤ą░ąĄčé čäčĆą░ą│ą╝ąĄąĮčéčŗ "ąĮą░ ą╗ąĄčéčā" ąĖ ąĘą░č鹥ą╝ ąŠčéčüčŗą╗ą░ąĄčé ąĖčģ.

ąÆ ą║ą░č湥čüčéą▓ąĄ č乊čĆą╝ą░čéą░ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓ ą▓čüąĄ ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĮčŗąĄ ą▓čŗčłąĄ ą▓ąĄą┤čāčēąĖąĄ č鹥čģąĮąŠą╗ąŠą│ąĖąĖ ą▓ č鹊ą╣ ąĖą╗ąĖ ąĖąĮąŠą╣ ą╝ąĄčĆąĄ ąĖčüą┐ąŠą╗čīąĘčāčÄčé čüčéą░ąĮą┤ą░čĆčéčŗ MPEG-2 TS [6] ąĖą╗ąĖ MPEG-4 Part 12 [7], ą▓ąĖą┤ąĄąŠą┐ąŠč鹊ą║ ąŠą▒čŗčćąĮąŠ čüąČąĖą╝ą░ąĄčéčüčÅ ą║ąŠą┤ąĄą║ąŠą╝ H.264 [8], ą░čāą┤ąĖąŠą┐ąŠč鹊ą║ čüąČąĖą╝ą░ąĄčéčüčÅ ą║ąŠą┤ąĄą║ąŠą╝ AAC [9].

ąÆąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą▓ ą▒čĆą░čāąĘąĄčĆąĄ ą║ą╗ąĖąĄąĮčéą░ ą┤ą╗čÅ ą║ą░ąČą┤ąŠą╣ ąĖąĘ ą┐čĆąĖą▓ąĄą┤ąĄąĮąĮčŗčģ ą▓čŗčłąĄ č湥čéčŗčĆąĄčģ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ ąĮąĄ ą╝ąŠąČąĄčé ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčīčüčÅ čü ą┐ąŠą╝ąŠčēčīčÄ "čćąĖčüč鹊ą│ąŠ" č鹥ą│ą░ <video>, ą░ čéčĆąĄą▒čāąĄčé ą┐ą╗ą░ą│ąĖąĮąŠą▓ ąĖą╗ąĖ ąĮą░ą┤čüčéčĆąŠąĄą║:

ąÆ ąĮą░čüč鹊čÅčēąĄą╣ čĆą░ą▒ąŠč鹥 ą┐čĆąĄą┤ą╗ą░ą│ą░ąĄčéčüčÅ ą▒ąŠą╗ąĄąĄ ą┐čĆąŠčüčéą░čÅ čüčģąĄą╝ą░ ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ ąČąĖą▓ąŠą│ąŠ ą▓ąĄčēą░ąĮąĖčÅ ąĮą░ą┤ HTTP, ą▓ ą║ąŠč鹊čĆąŠą╣ ąĮą░ čüč鹊čĆąŠąĮąĄ ą║ą╗ąĖąĄąĮčéą░ ą┐čĆąĖą╝ąĄąĮčÅąĄčéčüčÅ č鹥ą│ <video> ą▓ "čćąĖčüč鹊ą╝" ą▓ąĖą┤ąĄ, čé.ąĄ. ą▒ąĄąĘ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčŗčģ čĆą░čüčłąĖčĆąĄąĮąĖą╣, čéą░ą║ąĖčģ ą║ą░ą║ Media Source Extensions, Flash Player ąĖ čé.ą┐. ąĪčāčéčī ą┐čĆąĄą┤ą╗ą░ą│ą░ąĄą╝ąŠą╣ č鹥čģąĮąŠą╗ąŠą│ąĖąĖ ąĘą░ą║ą╗čÄčćą░ąĄčéčüčÅ ą▓ č鹊ą╝, čćč鹊 čüąĄčĆą▓ąĄčĆ č乊čĆą╝ąĖčĆčāąĄčé "ąĮą░ ą╗ąĄčéčā" ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ ą▓ ą▓ąĖą┤ąĄ ąĄą┤ąĖąĮąŠą│ąŠ ą┐ąŠč鹊ą║ąŠą▓ąŠą│ąŠ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ąĖ ąŠčéčüčŗą╗ą░ąĄčé ąĄą│ąŠ ą║ą╗ąĖąĄąĮčéčā ą┐ąŠ ą╝ąĄčĆąĄ čüąŠąĘą┤ą░ąĮąĖčÅ ą║ą░ąČą┤ąŠą│ąŠ ąŠč湥čĆąĄą┤ąĮąŠą│ąŠ čäčĆą░ą│ą╝ąĄąĮčéą░ čŹč鹊ą│ąŠ čäą░ą╣ą╗ą░. ąÜą╗ąĖąĄąĮčé ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ą┐čĆąĖąĄą╝ ąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ čŹč鹊ą│ąŠ čäą░ą╣ą╗ą░ čüčéą░ąĮą┤ą░čĆčéąĮčŗą╝ ą╝ąĄč鹊ą┤ąŠą╝ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ (Progressive Download).

ą¤čĆąĖą╝ąĄąĮąĖč鹥ą╗čīąĮąŠ ą║ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗čā ąŠą┐čĆąĄą┤ąĄą╗ąĖč鹥ą╗čīąĮąŠąĄ čüą╗ąŠą▓ąŠ "ą┐ąŠč鹊ą║ąŠą▓čŗą╣" ą▓ ą┤ą░ąĮąĮąŠą╝ čüą╗čāčćą░ąĄ čÅą▓ą╗čÅąĄčéčüčÅ čĆąĄčłą░čÄčēąĖą╝. ąÜą░ą║ ą┐ąŠą║ą░ąĘą░ąĮąŠ ąĮąĖąČąĄ, čŹč鹊 ą┤ą░ąĄčé ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ ą║ą╗ąĖąĄąĮčéą░ ą▓ ą┐čĆąŠąĖąĘą▓ąŠą╗čīąĮčŗą╣ ą╝ąŠą╝ąĄąĮčé ą║ čāąČąĄ ą▓ąĄą┤čāčēąĄą╣čüčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ. ąÆ ą║ą░č湥čüčéą▓ąĄ č乊čĆą╝ą░čéą░ ą┐ąŠč鹊ą║ąŠą▓ąŠą│ąŠ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą┐čĆąĄą┤ą╗ą░ą│ą░ąĄčéčüčÅ ą║ąŠąĮč鹥ą╣ąĮąĄčĆ Ogg [13] čü ą▓ąĖą┤ąĄąŠą║ąŠą┤ąĄą║ąŠą╝ Theora [14] ąĖ ą░čāą┤ąĖąŠą║ąŠą┤ąĄą║ąŠą╝ Vorbis [15]. ą¤ąŠą╝ąĖą╝ąŠ č鹊ą│ąŠ, čćč鹊 č乊čĆą╝ą░čé Ogg čÅą▓ą╗čÅąĄčéčüčÅ č乊čĆą╝ą░č鹊ą╝ ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░, č乊čĆą╝ą░čéčŗ Ogg, Theora ąĖ Vorbis ąĮąĄ ąĖą╝ąĄčÄčé ą║ą░ą║ąĖčģ-ą╗ąĖą▒ąŠ ą╗ąĖčåąĄąĮąĘąĖąŠąĮąĮčŗčģ ąĖą╗ąĖ ą┐ą░č鹥ąĮčéąĮčŗčģ ąŠą│čĆą░ąĮąĖč湥ąĮąĖą╣. ąØą░ čüč鹊čĆąŠąĮąĄ ą║ą╗ąĖąĄąĮčéą░ čŹčéąĖ č乊čĆą╝ą░čéčŗ ąĮą░ą┐čĆčÅą╝čāčÄ ą┐ąŠą┤ą┤ąĄčƹȹĖą▓ą░ąĄčéčüčÅ č鹥ą│ąŠą╝ <video> čÅąĘčŗą║ą░ HTML5 [16].

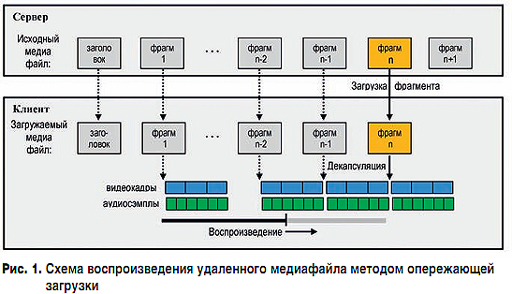

ą£ąĄč鹊ą┤ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ ŌĆō čŹč鹊 ą┐čĆąŠą│čĆą░ą╝ą╝ąĮą░čÅ čĆąĄą░ą╗ąĖąĘą░čåąĖčÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ąĮą░čćą░ą╗ą░ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą▒ąĄąĘ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéąĖ ąŠąČąĖą┤ą░ąĮąĖčÅ ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ ąĄą│ąŠ ą┐ąŠą╗ąĮąŠą│ąŠ čüą║ą░čćąĖą▓ą░ąĮąĖčÅ. ą£ąĄč鹊ą┤ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ ą┐čĆąĖą╝ąĄąĮčÅąĄčéčüčÅ ą┐ąŠą▓čüąĄą╝ąĄčüčéąĮąŠ ą┤ą╗čÅ ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ ą┐čĆąŠčüą╝ąŠčéčĆą░ ą║ą╗ąĖąĄąĮč鹊ą╝ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ąŠą▓, čĆą░čüą┐ąŠą╗ąŠąČąĄąĮąĮčŗčģ ąĮą░ čüąĄčĆą▓ąĄčĆąĄ. ąÆ čüąŠą▓čĆąĄą╝ąĄąĮąĮčŗčģ č乊čĆą╝ą░čéą░čģ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ąŠą▓ ą▓čüčÅ ąĖąĮč乊čĆą╝ą░čåąĖčÅ, ąĮąĄąŠą▒čģąŠą┤ąĖą╝ą░čÅ ą║ą╗ąĖąĄąĮčéčā ą┤ą╗čÅ č鹊ą│ąŠ, čćč鹊ą▒čŗ ąĮą░čćą░čéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ (čĆą░ąĘą╝ąĄčĆ ą║ą░ą┤čĆą░ ą▓ ą┐ąĖą║čüąĄą╗čÅčģ, čüą║ąŠčĆąŠčüčéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ąĖ čé.ą┐.), čüąŠą┤ąĄčƹȹĖčéčüčÅ ą▓ čüą░ą╝ąŠą╝ ąĮą░čćą░ą╗ąĄ čäą░ą╣ą╗ą░ ŌĆō ą▓ ąĄą│ąŠ ąĘą░ą│ąŠą╗ąŠą▓ą║ąĄ. ą¤ąŠčŹč鹊ą╝čā ą┐ąŠčüą╗ąĄ č鹊ą│ąŠ, ą║ą░ą║ ą║ą╗ąĖąĄąĮčé ą┐ąŠą╗čāčćąĖą╗ ąĘą░ą│ąŠą╗ąŠą▓ąŠą║ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ąĖ ąĄą│ąŠ ą┐ąĄčĆą▓čŗą╣ čäčĆą░ą│ą╝ąĄąĮčé, čüą┐ąŠčüąŠą▒ąĮčŗą╣ ą║ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÄ, ą║ą╗ąĖąĄąĮčé čāąČąĄ ą╝ąŠąČąĄčé ąĮą░čćą░čéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ąĄčēąĄ ą┤ąŠ ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ ą┐ąŠą╗ąĮąŠą╣ ąĘą░ą│čĆčāąĘą║ąĖ. ą¤ą░čĆą░ą╗ą╗ąĄą╗čīąĮąŠ čü ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄą╝ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą║ą╗ąĖąĄąĮčé ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ąĄą│ąŠ ą┤ąŠąĘą░ą│čĆčāąĘą║čā. ąĢčüą╗ąĖ ą┐čĆąĖ čŹč鹊ą╝ čüą║ąŠčĆąŠčüčéčī ąĘą░ą│čĆčāąĘą║ąĖ ą▒čāą┤ąĄčé ąĮąĄ ą╝ąĄąĮčīčłąĄ čüą║ąŠčĆąŠčüčéąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ, č鹊 ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ ą▒čāą┤ąĄčé ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčīčüčÅ ą│ą╗ą░ą┤ą║ąŠ, ą▒ąĄąĘ čĆčŗą▓ą║ąŠą▓. ąöą░ą╗ąĄąĄ ą┐čĆąŠčåąĄčüčü ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą╝ąĄč鹊ą┤ąŠą╝ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ čĆą░čüčüą╝ąŠčéčĆąĄąĮ ą▒ąŠą╗ąĄąĄ ą┐ąŠą┤čĆąŠą▒ąĮąŠ.

ąÜą╗ąĖąĄąĮčé ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé čüą║ą░čćąĖą▓ą░ąĮąĖąĄ ąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą┐čāč鹥ą╝ ąŠą▒čĆą░čēąĄąĮąĖčÅ ą║ č鹥ą│čā <video>, ą▓ ą║ąŠč鹊čĆąŠą╝ čāą║ą░ąĘčŗą▓ą░ąĄčéčüčÅ URL ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ąĖ ą░čéčĆąĖą▒čāčéčŗ č鹥ą│ą░, ą║ąŠč鹊čĆčŗąĄ ą┐ąĄčĆąĄą┤ą░čÄčéčüčÅ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤čÅčēąĄą╝čā ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ ą┐ą╗ąĄąĄčĆčā. ąÆčŗą┐ąŠą╗ąĮąĄąĮąĖąĄ č鹥ą│ą░ <video> ą┐čĆąŠąĖčüčģąŠą┤ąĖčé čüą╗ąĄą┤čāčÄčēąĖą╝ ąŠą▒čĆą░ąĘąŠą╝: ą▒čĆą░čāąĘąĄčĆ ą║ą╗ąĖąĄąĮčéą░ ą┤ąĄą╗ą░ąĄčé ąĘą░ą┐čĆąŠčü GET, ą║ąŠč鹊čĆčŗą╣ ąŠą▒čÅąĘą░č鹥ą╗čīąĮąŠ ą▓ą║ą╗čÄčćą░ąĄčé ą▓ čüąĄą▒čÅ čüčéą░čĆč鹊ą▓čāčÄ čüčéčĆąŠą║čā čü ą▓ąŠąĘą╝ąŠąČąĮčŗą╝ąĖ ą┐ą░čĆą░ą╝ąĄčéčĆą░ą╝ąĖ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖčÅ ąĘą░ą┐čĆąŠčüą░ ąĖ ąĘą░ą│ąŠą╗ąŠą▓ą║ą░ą╝ąĖ, čüąĄčĆą▓ąĄčĆ ąŠčéčüčŗą╗ą░ąĄčé ą║ą╗ąĖąĄąĮčéčā ąŠčéą▓ąĄčé "HTTP/1.1 200 OK", ą░ čéą░ą║ąČąĄ ą╝ąŠąČąĄčé ą▓ ąĘą░ą▓ąĖčüąĖą╝ąŠčüčéąĖ ąŠčé ą┐čĆąĄą┤ą┐ąŠčćč鹥ąĮąĖą╣ ą║ą╗ąĖąĄąĮčéą░ ąĖąĘą╝ąĄąĮčÅčéčī ą┤ą╗čÅ ąĮąĄą│ąŠ č鹥čģąĮąĖč湥čüą║ąĖąĄ ą┐ą░čĆą░ą╝ąĄčéčĆčŗ čéčĆą░ąĮčüą╗čÅčåąĖąĖ. ą¤ąŠčüą╗ąĄ čŹč鹊ą│ąŠ ą▒čĆą░čāąĘąĄčĆ ą║ą╗ąĖąĄąĮčéą░ ąĮą░čćąĖąĮą░ąĄčé č乊ąĮąŠą▓čāčÄ ąĘą░ą│čĆčāąĘą║čā ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ čü ąĄą│ąŠ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮčŗą╝ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄą╝.

ąÆ ą┤ą░ą╗čīąĮąĄą╣čłąĄą╝ ą▒čāą┤ąĄą╝ ą┐čĆąĄą┤čüčéą░ą▓ą╗čÅčéčī ąĘą░ą│čĆčāąČą░ąĄą╝čŗą╣ čäą░ą╣ą╗ ą▓ ą▓ąĖą┤ąĄ čĆą░čüą┐ąŠą╗ąŠąČąĄąĮąĮčŗčģ ą┐ąŠčüą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīąĮąŠ ąŠą┤ąĖąĮ ąĘą░ ą┤čĆčāą│ąĖą╝ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓. ą¤ąŠą┤ čäčĆą░ą│ą╝ąĄąĮč鹊ą╝ ą▒čāą┤ąĄą╝ ą┐ąŠąĮąĖą╝ą░čéčī ąĄą┤ąĖąĮąĖčćąĮčŗą╣ 菹╗ąĄą╝ąĄąĮčé ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, ą║ąŠč鹊čĆčŗą╣ ą╝ąŠąČąĄčé ą▒čŗčéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮ ą▒ąĄąĘ ąĘąĮą░ąĮąĖčÅ ą┤čĆčāą│ąĖčģ čćą░čüč鹥ą╣ čäą░ą╣ą╗ą░ (ą║čĆąŠą╝ąĄ ąĘą░ą│ąŠą╗ąŠą▓ą║ą░ čäą░ą╣ą╗ą░). ą×čéčüčÄą┤ą░ čüą╗ąĄą┤čāąĄčé, čćč鹊 čäčĆą░ą│ą╝ąĄąĮčé ą┤ąŠą╗ąČąĄąĮ čüąŠą┤ąĄčƹȹ░čéčī čåąĄą╗ąŠąĄ čćąĖčüą╗ąŠ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆąŠą▓ ąĖ čåąĄą╗ąŠąĄ čćąĖčüą╗ąŠ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ąŠą▓. ą£ąĖąĮąĖą╝ą░ą╗čīąĮčŗą╝ čÅą▓ą╗čÅąĄčéčüčÅ čäčĆą░ą│ą╝ąĄąĮčé čü ąŠą┤ąĮąĖą╝ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆąŠą╝ (ąĖ čü čüąŠąŠčéą▓ąĄčéčüčéą▓čāčÄčēąĖą╝ čćąĖčüą╗ąŠą╝ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ąŠą▓).

ąŚą░ą│čĆčāąĘą║ą░ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ čüąŠčüč鹊ąĖčé ą▓ ą┐ąĄčĆąĄą┤ą░č湥 čü čüąĄčĆą▓ąĄčĆą░ ąĮą░ ą║ą╗ąĖąĄąĮčé ą▓čüąĄą│ąŠ čüąŠą┤ąĄčƹȹĖą╝ąŠą│ąŠ čäą░ą╣ą╗ą░, ą║ąŠč鹊čĆą░čÅ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčüčÅ ąĮąĄą▒ąŠą╗čīčłąĖą╝ąĖ ą┐ąŠčĆčåąĖčÅą╝ąĖ. ąöą╗čÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą║ą╗ąĖąĄąĮč鹊ą╝ čüčĆą░ąĘčā ą┐ąŠčüą╗ąĄ ąĘą░ą│čĆčāąĘą║ąĖ ą┐ąĄčĆą▓ąŠą│ąŠ čäčĆą░ą│ą╝ąĄąĮčéą░ ą║ą╗ąĖąĄąĮčé ą▓ąĮą░čćą░ą╗ąĄ ą┤ąŠą╗ąČąĄąĮ ą┐ąŠą╗čāčćąĖčéčī ąĘą░ą│ąŠą╗ąŠą▓ąŠą║ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, ą▓ ą║ąŠč鹊čĆąŠą╝ čüąŠą┤ąĄčƹȹ░čéčüčÅ ą┐ą░čĆą░ą╝ąĄčéčĆčŗ, ąĮąĄąŠą▒čģąŠą┤ąĖą╝čŗąĄ ą┤ą╗čÅ ąĮą░čćą░ą╗ą░ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ (čćą░čüč鹊čéą░ ą║ą░ą┤čĆąŠą▓, čćą░čüč鹊čéą░ čüąĄą╝ą┐ą╗ąĖčĆąŠą▓ą░ąĮąĖčÅ, čĆą░ąĘčĆąĄčłąĄąĮąĖąĄ 菹║čĆą░ąĮą░ ąĖ čé.ą┐.).

ą¤ąŠą╗čāčćąĖą▓ ąĘą░ą│ąŠą╗ąŠą▓ąŠą║, ą║ą╗ąĖąĄąĮčé čüą╝ąŠąČąĄčé ąĮą░čćą░čéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ čüčĆą░ąĘčā ą┐ąŠčüą╗ąĄ č鹊ą│ąŠ, ą║ą░ą║ ą▓ ą▒čāč乥čĆąĄ ąŠą║ą░ąČąĄčéčüčÅ ą┐ąĄčĆą▓čŗą╣ čäčĆą░ą│ą╝ąĄąĮčé čäą░ą╣ą╗ą░. ąĢčüą╗ąĖ ą║ą░ąČą┤čŗą╣ čĆą░ąĘ ą║ ą╝ąŠą╝ąĄąĮčéčā ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą║ą╗ąĖąĄąĮč鹊ą╝ ąŠč湥čĆąĄą┤ąĮąŠą│ąŠ čäčĆą░ą│ą╝ąĄąĮčéą░ ą▓ ą▒čāč乥čĆąĄ ąŠą║ą░ąĘčŗą▓ą░ąĄčéčüčÅ čüą╗ąĄą┤čāčÄčēąĖą╣ ąĘą░ ąĮąĖą╝ čäčĆą░ą│ą╝ąĄąĮčé, ą║ą╗ąĖąĄąĮčé ą▒čāą┤ąĄčé ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčī ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ ą┐ą╗ą░ą▓ąĮąŠ. ąśąĮčŗą╝ąĖ čüą╗ąŠą▓ą░ą╝ąĖ, ą▓ ą║ą░ąČą┤čŗą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ ą▓ ą▒čāč乥čĆąĄ ą┤ąŠą╗ąČąĮąŠ čüąŠą┤ąĄčƹȹ░čéčīčüčÅ ą┤ąŠčüčéą░č鹊čćąĮąŠąĄ ą║ąŠą╗ąĖč湥čüčéą▓ąŠ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓ ą┤ą╗čÅ ąŠą▒ąĄčüą┐ąĄč湥ąĮąĖčÅ ąĮąĄą┐čĆąĄčĆčŗą▓ąĮąŠčüčéąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ. ąÆčĆąĄą╝ąĄąĮąĮą░čÅ ą┤ą╗ąĖč鹥ą╗čīąĮąŠčüčéčī čäčĆą░ą│ą╝ąĄąĮčéą░ ąĘą░ą┤ą░ąĄčé ą╝ąĖąĮąĖą╝ą░ą╗čīąĮčāčÄ ąĘą░ą┤ąĄčƹȹ║čā ą╝ąĄąČą┤čā ą▓čĆąĄą╝ąĄąĮąĄą╝ ąĮą░čćą░ą╗ąŠą╝ ąĘą░ą│čĆčāąĘą║ąĖ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ąĖ ą▓čĆąĄą╝ąĄąĮąĄą╝ ąĮą░čćą░ą╗ą░ ąĄą│ąŠ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ.

ąØą░ čĆąĖčü. 1 ą┐čĆąĄą┤čüčéą░ą▓ą╗ąĄąĮą░ ąĖą╗ą╗čÄčüčéčĆą░čåąĖčÅ ą┐čĆąŠčåąĄčüčüą░ ą┐čĆąŠąĖą│čĆčŗą▓ą░ąĮąĖčÅ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ čü ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąŠą╣. ąöą╗čÅ čāą┐čĆąŠčēąĄąĮąĖčÅ ą║ą░čĆčéąĖąĮčŗ ąĖąĘąŠą▒čĆą░ąČąĄąĮ ą│ąĖą┐ąŠč鹥čéąĖč湥čüą║ąĖą╣ čüą╗čāčćą░ą╣, ą║ąŠą│ą┤ą░ čäčĆą░ą│ą╝ąĄąĮčé čüąŠą┤ąĄčƹȹĖčé čéčĆąĖ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆą░, ą░ ąĮą░ ąŠą┤ąĖąĮ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆ ą┐čĆąĖčģąŠą┤ąĖčéčüčÅ ą┤ą▓ą░ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ą░ (ą▓ čĆąĄą░ą╗čīąĮąŠčüčéąĖ ąĮą░ ąŠą┤ąĖąĮ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆ ą┐čĆąĖčģąŠą┤ąĖčéčüčÅ ą│ąŠčĆą░ąĘą┤ąŠ ą▒ąŠą╗čīčłąĄ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ąŠą▓). ąØą░ čĆąĖčü. 1 ąĖąĘąŠą▒čĆą░ąČąĄąĮą░ čüąĖčéčāą░čåąĖčÅ, ą║ąŠą│ą┤ą░ ą║ą╗ąĖąĄąĮčé čāąČąĄ ąĘą░ą│čĆčāąĘąĖą╗ čü čüąĄčĆą▓ąĄčĆą░ čäčĆą░ą│ą╝ąĄąĮčéčŗ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ čü ą┐ąĄčĆą▓ąŠą│ąŠ ą┐ąŠ n-1. ąÆ č鹥ą║čāčēąĖą╣ ą╝ąŠą╝ąĄąĮčé ą║ą╗ąĖąĄąĮčé ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ąĘą░ą│čĆčāąĘą║čā ąĖ ą┐ąŠčüą╗ąĄą┤čāčÄčēčāčÄ ą┤ąĄą║ą░ą┐čüčāą╗čÅčåąĖčÄ čäčĆą░ą│ą╝ąĄąĮčéą░ n. ą×ą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ čü čŹčéąĖą╝ ą║ą╗ąĖąĄąĮčé ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ą╝ąĄą┤ąĖą░, čüąŠą┤ąĄčƹȹ░čēąĄąĄčüčÅ ą▓ąŠ čäčĆą░ą│ą╝ąĄąĮč鹥 n-2.

ąÆ ąĮąĖąČąĮąĄą╣ čćą░čüčéąĖ čĆąĖčü. 1 ąĖąĘąŠą▒čĆą░ąČąĄąĮ ąĖąĮą┤ąĖą║ą░č鹊čĆ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖčÅ (Progress Bar), ąĮą░ą│ą╗čÅą┤ąĮąŠ ąŠč鹊ą▒čĆą░ąČą░čÄčēąĖą╣ ą┐čĆąŠčåąĄčüčü ąĘą░ą│čĆčāąĘą║ąĖ ąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░. ąÆčüčÅ ą│ąŠčĆąĖąĘąŠąĮčéą░ą╗čīąĮą░čÅ ą╗ąĖąĮąĖčÅ ąĖąĮą┤ąĖą║ą░č鹊čĆą░ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖčÅ čüčģąĄą╝ą░čéąĖčćąĮąŠ ąĖąĘąŠą▒čĆą░ąČą░ąĄčé ą▓čĆąĄą╝ąĄąĮąĮčāčÄ ą┤ą╗ąĖč鹥ą╗čīąĮąŠčüčéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą▓čüąĄčģ ąĘą░ą│čĆčāąČąĄąĮąĮčŗčģ ąĮą░ č鹥ą║čāčēąĖą╣ ą╝ąŠą╝ąĄąĮčé čäčĆą░ą│ą╝ąĄąĮč鹊ą▓ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, č鹊ą│ą┤ą░ ą║ą░ą║ ą╗ąĄą▓čŗą╣ ąŠčéčĆąĄąĘąŠą║ čŹč鹊ą╣ ą╗ąĖąĮąĖąĖ č湥čĆąĮąŠą│ąŠ čåą▓ąĄčéą░ ąŠč鹊ą▒čĆą░ąČą░ąĄčé ą▓čĆąĄą╝ąĄąĮąĮčāčÄ ą┤ą╗ąĖč鹥ą╗čīąĮąŠčüčéčī čāąČąĄ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĮąŠą╣ čćą░čüčéąĖ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░. ąÜąŠčĆąŠčéą║ąĖą╣ ą▓ąĄčĆčéąĖą║ą░ą╗čīąĮčŗą╣ ąŠčéčĆąĄąĘąŠą║ ą┐ąŠą║ą░ąĘčŗą▓ą░ąĄčé ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ č鹥ą║čāčēąĄą│ąŠ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ, ą║ąŠą│ą┤ą░ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤čÅčéčüčÅ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆčŗ ąĖ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗čŗ, čüąŠą┤ąĄčƹȹ░čēąĖąĄčüčÅ ą▓ąŠ čäčĆą░ą│ą╝ąĄąĮč鹥 n-2.

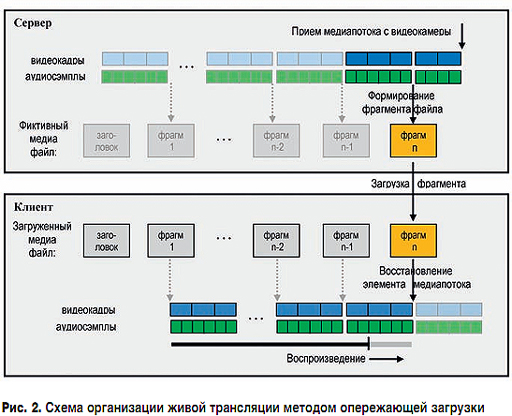

ąśąĘą╗ąŠąČąĄąĮąĮą░čÅ ą▓ ą┐čĆąĄą┤čŗą┤čāčēąĄą╣ čćą░čüčéąĖ čüčéą░čéčīąĖ čüčģąĄą╝ą░ čłąĖčĆąŠą║ąŠ ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ ą┤ą╗čÅ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ čāąČąĄ ą┐ąŠą╗ąĮąŠčüčéčīčÄ čüč乊čĆą╝ąĖčĆąŠą▓ą░ąĮąĮąŠą│ąŠ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, ąŠą┤ąĮą░ą║ąŠ ąĮąĖčćč鹊 ąĮąĄ ą╝ąĄčłą░ąĄčé ąĄąĄ ą┐čĆąĖą╝ąĄąĮąĖčéčī ą┤ą╗čÅ ąČąĖą▓ąŠą╣ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą┐čĆąĄąĘąĄąĮčéą░čåąĖąĖ, ąĄčüą╗ąĖ ą┐ąĄčĆąĄą┤ą░ą▓ą░ąĄą╝čŗą╣ ą║ą╗ąĖąĄąĮčéčā ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ čĆą░čüčüą╝ą░čéčĆąĖą▓ą░čéčī ą║ą░ą║ čäą░ą╣ą╗, čüąŠąĘą┤ą░ą▓ą░ąĄą╝čŗą╣ čüąĄčĆą▓ąĄčĆąŠą╝ ą┐ąŠ čģąŠą┤čā čéčĆą░ąĮčüą╗čÅčåąĖąĖ "ąĮą░ ą╗ąĄčéčā". ąĪ č鹊čćą║ąĖ ąĘčĆąĄąĮąĖčÅ ą║ą╗ąĖąĄąĮčéą░ ą▒čāą┤ąĄčé ą┐čĆąŠąĖčüčģąŠą┤ąĖčéčī ąŠą▒čŗčćąĮąŠąĄ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ čü ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąŠą╣. ąĪąĄčĆą▓ąĄčĆ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ąĖą╝ąĖčéą░čåąĖčÄ ąŠčéą┐čĆą░ą▓ą║ąĖ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░ ą║ą╗ąĖąĄąĮčéčā, čģąŠčéčÅ ąĮąĖą║ą░ą║ąŠą│ąŠ čäą░ą╣ą╗ą░ ąĮąĄ čüčāčēąĄčüčéą▓čāąĄčé, ą░ ą║ą░ąČą┤čŗą╣ čĆą░ąĘ čüąŠąĘą┤ą░ąĄčéčüčÅ ąŠč湥čĆąĄą┤ąĮąŠą╣ čäčĆą░ą│ą╝ąĄąĮčé, ą║ąŠč鹊čĆčŗą╣ čéčāčé ąČąĄ ąŠčéčüčŗą╗ą░ąĄčéčüčÅ ą║ą╗ąĖąĄąĮčéčā. ąĪąĄčĆą▓ąĄčĆ ą▓ąĄą┤ąĄčé ąĘą░ą┐ąĖčüčī ąČąĖą▓ąŠą│ąŠ ą▓ąĄčēą░ąĮąĖčÅ ą▓ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╣ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗. ąŁč鹊čé čäą░ą╣ą╗ ąĮą░ąĘą▓ą░ąĮ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╝, ą┐ąŠčüą║ąŠą╗čīą║čā ąŠąĮ čüąŠąĘą┤ą░ąĄčéčüčÅ ą▓ ąŠą┐ąĄčĆą░čéąĖą▓ąĮąŠą╣ ą┐ą░ą╝čÅčéąĖ čüąĄčĆą▓ąĄčĆą░, ą░ ąĮąĄ ąĮą░ ą┤ąĖčüą║ąĄ. ąÆ čĆąĄą░ą╗čīąĮąŠčüčéąĖ ą▓ ąŠą┐ąĄčĆą░čéąĖą▓ąĮąŠą╣ ą┐ą░ą╝čÅčéąĖ ąĮą░čģąŠą┤ąĖčéčüčÅ č鹊ą╗čīą║ąŠ ą▒čāč乥čĆ, ą▓ ą║ąŠč鹊čĆąŠą╝ čģčĆą░ąĮčÅčéčüčÅ ą┤ą▓ą░ čäčĆą░ą│ą╝ąĄąĮčéą░ ŌĆō ą┐čĆąĄą┤čŗą┤čāčēąĖą╣ ą┤ą╗čÅ ąŠčéčüčŗą╗ą║ąĖ ą║ą╗ąĖąĄąĮčéčā ąĖ č鹥ą║čāčēąĖą╣ ą┤ą╗čÅ ąĄą│ąŠ č乊čĆą╝ąĖčĆąŠą▓ą░ąĮąĖčÅ. ą¤ąŠ ą╝ąĄčĆąĄ ą┐čĆąĖąĄą╝ą░ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆąŠą▓ ąĖ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ąŠą▓ čüąĄčĆą▓ąĄčĆ č乊čĆą╝ąĖčĆčāąĄčé č鹥ą║čāčēąĖą╣ čäčĆą░ą│ą╝ąĄąĮčé. ąĪčĆą░ąĘčā ą┐ąŠčüą╗ąĄ ąĘą░ą┐ąĖčüąĖ ą▓ ą▒čāč乥čĆ č鹊ą╗čīą║ąŠ čćč鹊 čüč乊čĆą╝ąĖčĆąŠą▓ą░ąĮąĮąŠą│ąŠ č鹥ą║čāčēąĄą│ąŠ čäčĆą░ą│ą╝ąĄąĮčéą░ čüąĄčĆą▓ąĄčĆ ą┤ąĄą╗ą░ąĄčé ąĄą│ąŠ ą┐čĆąĄą┤čŗą┤čāčēąĖą╝ ąĖ ąĮą░čćąĖąĮą░ąĄčé ąŠčéą┐čĆą░ą▓ą╗čÅčéčī ą║ą╗ąĖąĄąĮčéčā.

ąØą░ čĆąĖčü. 2 ą┐čĆąĖą▓ąĄą┤ąĄąĮą░ ąĖą╗ą╗čÄčüčéčĆą░čåąĖčÅ ąĖąĘą╗ąŠąČąĄąĮąĮąŠą╣ čüčģąĄą╝čŗ ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ ąČąĖą▓ąŠą╣ čéčĆą░ąĮčüą╗čÅčåąĖąĖ čü ą┐čĆąĖą╝ąĄąĮąĄąĮąĖąĄą╝ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ.

ąØą░ čĆąĖčü. 2 ąĖąĘąŠą▒čĆą░ąČąĄąĮą░ čüąĖčéčāą░čåąĖčÅ, ą║ąŠą│ą┤ą░ čüąĄčĆą▓ąĄčĆ ąĘą░ą║ąŠąĮčćąĖą╗ ą┐čĆąĖąĄą╝ ąŠč湥čĆąĄą┤ąĮąŠą│ąŠ 菹╗ąĄą╝ąĄąĮčéą░ ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░ (čéčĆąĄčģ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆąŠą▓ ąĖ čłąĄčüčéąĖ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ąŠą▓), ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠą│ąŠ ą┤ą╗čÅ č乊čĆą╝ąĖčĆąŠą▓ą░ąĮąĖčÅ čäčĆą░ą│ą╝ąĄąĮčéą░ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, čüč乊čĆą╝ąĖčĆąŠą▓ą░ą╗ čäčĆą░ą│ą╝ąĄąĮčé n ąĖ ąŠč鹊čüą╗ą░ą╗ ąĄą│ąŠ ą║ą╗ąĖąĄąĮčéčā. ą×ą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ čü čŹčéąĖą╝ čüąĄčĆą▓ąĄčĆ ą┐čĆąĖąĮąĖą╝ą░ąĄčé ąŠčé ą▓ąĖą┤ąĄąŠą║ą░ą╝ąĄčĆčŗ čüą╗ąĄą┤čāčÄčēąĖąĄ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆčŗ ąĖ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗čŗ, ąŠąĮ čāąČąĄ ą┐čĆąĖąĮčÅą╗ ą┤ą▓ą░ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆą░ ąĖ č湥čéčŗčĆąĄ ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ą░. ąÜą╗ąĖąĄąĮčé ąĘą░ą│čĆčāąĘąĖą╗ čäčĆą░ą│ą╝ąĄąĮčé n ąĖ ą▓ąŠčüčüčéą░ąĮąŠą▓ąĖą╗ ąĖąĘ ąĮąĄą│ąŠ ą┐ąĄčĆą▓ąŠąĮą░čćą░ą╗čīąĮčŗą╣ 菹╗ąĄą╝ąĄąĮčé ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░ (čéčĆąĖ ą▓ąĖą┤ąĄąŠą║ą░ą┤čĆą░ ąĖ čłąĄčüčéčī ą░čāą┤ąĖąŠčüąĄą╝ą┐ą╗ąŠą▓). ą×ą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ čü čŹčéąĖą╝ ą║ą╗ąĖąĄąĮčé ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčé ą╝ąĄą┤ąĖą░, čüąŠą┤ąĄčƹȹ░ą▓čłąĄąĄčüčÅ ą▓ čĆą░ąĮąĄąĄ ą┐čĆąĖąĮčÅč鹊ą╝ čäčĆą░ą│ą╝ąĄąĮč鹥 n-1.

ąØą░ čĆąĖčü. 1 ąĖ 2 ą┐čĆąĄą┤ą┐ąŠą╗ą░ą│ą░ąĄčéčüčÅ, čćč鹊 ą┐čĆąŠčåąĄčüčüčŗ ą┐čĆąĄąŠą▒čĆą░ąĘąŠą▓ą░ąĮąĖčÅ "菹╗ąĄą╝ąĄąĮčé ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░ → čäčĆą░ą│ą╝ąĄąĮčé" ąĖ "čäčĆą░ą│ą╝ąĄąĮčé → 菹╗ąĄą╝ąĄąĮčé ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░", ą░ čéą░ą║ąČąĄ ą┐ąĄčĆąĄą┤ą░čćąĖ čäčĆą░ą│ą╝ąĄąĮčéą░ ąŠčé čüąĄčĆą▓ąĄčĆą░ ą║ ą║ą╗ąĖąĄąĮčéčā ą┐čĆąŠąĖčüčģąŠą┤čÅčé ą╝ą│ąĮąŠą▓ąĄąĮąĮąŠ. ąśąĘ čĆąĖčü. 2 ą▓ąĖą┤ąĮąŠ, čćč鹊 ąĄčüą╗ąĖ čäčĆą░ą│ą╝ąĄąĮčé čüąŠą┤ąĄčƹȹĖčé ąŠą┤ąĖąĮ ą║ą░ą┤čĆ, č鹊 ą┐čĆąĖ čćą░čüč鹊č鹥 ą▓ N ą║ą░ą┤čĆąŠą▓ ą▓ čüąĄą║čāąĮą┤čā ą╝ąĖąĮąĖą╝ą░ą╗čīąĮą░čÅ ąĘą░ą┤ąĄčƹȹ║ą░ ą╝ąĄąČą┤čā ą▓čĆąĄą╝ąĄąĮąĄą╝ ą┐čĆąĖąĄą╝ą░ ą╝ąĄą┤ąĖą░ čü ą▓ąĖą┤ąĄąŠą║ą░ą╝ąĄčĆčŗ ąĖ ą▓čĆąĄą╝ąĄąĮąĄą╝ ąŠč鹊ą▒čĆą░ąČąĄąĮąĖčÅ ą╝ąĄą┤ąĖą░ čā ą║ą╗ąĖąĄąĮčéą░ ą▒čāą┤ąĄčé čüąŠčüčéą░ą▓ą╗čÅčéčī 1/N čüąĄą║čāąĮą┤, čé.ąĄ. ą╝ąĄąĮąĄąĄ ąŠą┤ąĮąŠą╣ čüąĄą║čāąĮą┤čŗ.

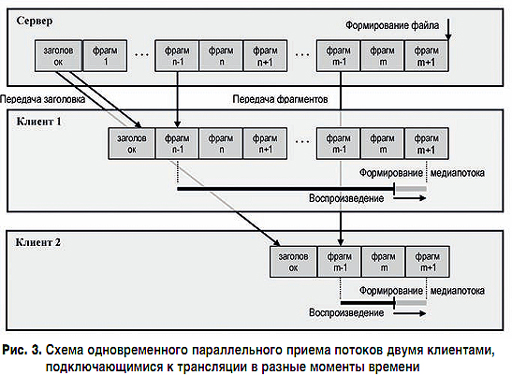

ąśąĘ ąĖąĘą╗ąŠąČąĄąĮąĮąŠą╣ čüčģąĄą╝čŗ čéą░ą║ąČąĄ čüą╗ąĄą┤čāąĄčé, čćč鹊 ą║ą╗ąĖąĄąĮčé ą╝ąŠąČąĄčé ą┐ąŠą┤ą║ą╗čÄčćąĖčéčīčüčÅ ą║ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą┐čĆąĄąĘąĄąĮčéą░čåąĖąĖ ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ. ąÆąĮą░čćą░ą╗ąĄ ąŠąĮ ą┐ąŠą╗čāčćąĖčé ąĘą░ą│ąŠą╗ąŠą▓ąŠą║ čäą░ą╣ą╗ą░, ą░ ąĘą░č鹥ą╝ ąĮą░čćąĮąĄčé ą┐čĆąĖąĮąĖą╝ą░čéčī čäčĆą░ą│ą╝ąĄąĮčéčŗ, ąĮą░čćąĖąĮą░čÅ čü ą╝ąŠą╝ąĄąĮčéą░ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ ą║ čéčĆą░ąĮčüą╗čÅčåąĖąĖ. ąóą░ą║ąĖą╝ ąŠą▒čĆą░ąĘąŠą╝, ąĖą╝ąĄąĄčéčüčÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ąŠčĆą│ą░ąĮąĖąĘąŠą▓ą░čéčī ą┐ą░čĆą░ą╗ą╗ąĄą╗čīąĮčāčÄ čéčĆą░ąĮčüą╗čÅčåąĖčÄ ą┐čĆąĄąĘąĄąĮčéą░čåąĖąĖ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ ą║ą╗ąĖąĄąĮčéą░ą╝, ą┐ąŠą┤ą║ą╗čÄčćą░čÄčēąĖą╝čüčÅ ą║ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą┐ąŠ čģąŠą┤čā ąĄąĄ ą┐čĆąŠą▓ąĄą┤ąĄąĮąĖčÅ. ąØą░ čĆąĖčü. 3 ą┐ąŠą║ą░ąĘą░ąĮą░ čüčģąĄą╝ą░ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ ą┤ą▓čāčģ ą║ą╗ąĖąĄąĮč鹊ą▓ ą║ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą┐čĆąĄąĘąĄąĮčéą░čåąĖąĖ ą▓ čĆą░ąĘąĮčŗąĄ ą╝ąŠą╝ąĄąĮčéčŗ ą▓čĆąĄą╝ąĄąĮąĖ.

ą¤ąĄčĆą▓čŗą╣ ą║ą╗ąĖąĄąĮčé ą┐ąŠą┤ą║ą╗čÄčćąĖą╗čüčÅ ą║ čüąĄčĆą▓ąĄčĆčā ą▓ č鹊čé ą╝ąŠą╝ąĄąĮčé, ą║ąŠą│ą┤ą░ čüąĄčĆą▓ąĄčĆ č鹊ą╗čīą║ąŠ čćč鹊 čüąŠąĘą┤ą░ą╗ čäčĆą░ą│ą╝ąĄąĮčé n-1. ąĪąĄčĆą▓ąĄčĆ ą▓ąĮą░čćą░ą╗ąĄ ą┐ąĄčĆąĄą┤ą░ąĄčé ąĄą╝čā čäčĆą░ą│ą╝ąĄąĮčé čü ąĘą░ą│ąŠą╗ąŠą▓ą║ąŠą╝ ą┐ąŠč鹊ą║ą░, ą░ ąĘą░č鹥ą╝ ąĮą░čćąĖąĮą░ąĄčé ą┐ąĄčĆąĄą┤ą░ą▓ą░čéčī ą╝ąĄą┤ąĖą░ą┤ą░ąĮąĮčŗąĄ, ąĮą░čćąĖąĮą░čÅ čü čäčĆą░ą│ą╝ąĄąĮčéą░ n-1. ąÆč鹊čĆąŠą╣ ą║ą╗ąĖąĄąĮčé ą┐ąŠą┤ą║ą╗čÄčćąĖą╗čüčÅ ą║ čüąĄčĆą▓ąĄčĆčā čüčĆą░ąĘčā ą┐ąŠčüą╗ąĄ čüąŠąĘą┤ą░ąĮąĖčÅ čäčĆą░ą│ą╝ąĄąĮčéą░ m-1. ąĪąĄčĆą▓ąĄčĆ ą▓ąĮą░čćą░ą╗ąĄ ą┐ąĄčĆąĄą┤ą░ąĄčé ąĄą╝čā čäčĆą░ą│ą╝ąĄąĮčé čü ąĘą░ą│ąŠą╗ąŠą▓ą║ąŠą╝ ą┐ąŠč鹊ą║ą░, ą░ ąĘą░č鹥ą╝ ą╝ąĄą┤ąĖą░ą┤ą░ąĮąĮčŗąĄ, ąĮą░čćąĖąĮą░čÅ čü čäčĆą░ą│ą╝ąĄąĮčéą░ m-1.

ąĀąĄąĘčÄą╝ąĖčĆčāčÅ ą▓čüąĄ čüą║ą░ąĘą░ąĮąĮąŠąĄ ą▓čŗčłąĄ, ą╝ąŠąČąĮąŠ ą▓čŗą┤ąĄą╗ąĖčéčī čüą╗ąĄą┤čāčÄčēąĖąĄ čüą▓ąŠą╣čüčéą▓ą░ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░, ą┤ąĄą╗ą░čÄčēąĖąĄ ą▓ąŠąĘą╝ąŠąČąĮčŗą╝ ąĄą│ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą▓ ą║ą░č湥čüčéą▓ąĄ č乊čĆą╝ą░čéą░ ą┐ąŠč鹊ą║ą░ ąČąĖą▓ąŠą╣ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąĄč鹊ą┤ąŠą╝ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ:

ąÆčüąĄą╝ čŹčéąĖą╝ čüą▓ąŠą╣čüčéą▓ą░ą╝ čāą┤ąŠą▓ą╗ąĄčéą▓ąŠčĆčÅąĄčé č乊čĆą╝ą░čé Ogg, ą║ąŠč鹊čĆčŗą╣ ąĖ ą▒čāą┤ąĄčé ą┐ąŠą┤čĆą░ąĘčāą╝ąĄą▓ą░čéčīčüčÅ ą▓ ą┤ą░ą╗čīąĮąĄą╣čłąĄą╝. ąÜąŠąĮč鹥ą╣ąĮąĄčĆ Ogg ą╝ąŠąČąĄčé čüąŠą┤ąĄčƹȹ░čéčī ąĮąĄčüą║ąŠą╗čīą║ąŠ ą┐ąŠč鹊ą║ąŠą▓, ą▓ ąĮą░čłąĄą╝ čüą╗čāčćą░ąĄ ąĖčģ ą┤ą▓ą░ ŌĆō ą┐ąŠč鹊ą║ ą▓ąĖą┤ąĄąŠ ąĖ ą┐ąŠč鹊ą║ ą░čāą┤ąĖąŠ. ą¤ąŠč鹊ą║ č乊čĆą╝ą░čéą░ Ogg čüąŠčüč鹊ąĖčé ąĖąĘ čéą░ą║ ąĮą░ąĘčŗą▓ą░ąĄą╝čŗčģ čüčéčĆą░ąĮąĖčå, ą║ąŠč鹊čĆčŗąĄ ąĖą│čĆą░čÄčé čĆąŠą╗čī čäčĆą░ą│ą╝ąĄąĮč鹊ą▓. ąÜą░ąČą┤ą░čÅ čüčéčĆą░ąĮąĖčåą░, ą┐ąŠą╝ąĖą╝ąŠ ą╝ąĄą┤ąĖą░ą┤ą░ąĮąĮčŗčģ, čüąŠą┤ąĄčƹȹĖčé čüą╗čāąČąĄą▒ąĮčāčÄ ąĖąĮč乊čĆą╝ą░čåąĖčÄ ąŠ ą┐čĆąĖąĮą░ą┤ą╗ąĄąČąĮąŠčüčéąĖ čŹč鹊ą╣ čüčéčĆą░ąĮąĖčåčŗ ą║ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮąŠą╝čā ą┐ąŠč鹊ą║čā, ąĄąĄ ą┐ąŠčĆčÅą┤ą║ąŠą▓čŗą╣ ąĮąŠą╝ąĄčĆ ą▓ ą┐ąŠč鹊ą║ąĄ, ąĖąĮč乊čĆą╝ą░čåąĖčÄ ąŠ ą╝ąŠą╝ąĄąĮč鹥 ą▓čĆąĄą╝ąĄąĮąĖ, čü ą║ąŠč鹊čĆąŠą│ąŠ ąĮčāąČąĮąŠ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčī ą╝ąĄą┤ąĖą░ą┤ą░ąĮąĮčŗąĄ čŹč鹊ą╣ čüčéčĆą░ąĮąĖčåčŗ. ą¤ąĄčĆą▓čŗąĄ ą┤ą▓ąĄ čüčéčĆą░ąĮąĖčåčŗ ą┐ąŠč鹊ą║ą░ ą┐ąŠą┤ ąĮąŠą╝ąĄčĆą░ą╝ąĖ 0 ąĖ 1 čÅą▓ą╗čÅčÄčéčüčÅ ąĘą░ą│ąŠą╗ąŠą▓ą║ąŠą╝ ą┐ąŠč鹊ą║ą░ Ogg ąĖ čüąŠą┤ąĄčƹȹ░čé čüą╗čāąČąĄą▒ąĮčāčÄ ąĖąĮč乊čĆą╝ą░čåąĖčÄ ąŠą▒ąŠ ą▓čüąĄą╝ ą┐ąŠč鹊ą║ąĄ ŌĆō čĆą░ąĘčĆąĄčłąĄąĮąĖąĄ 菹║čĆą░ąĮą░, ą▒ąĖčéčĆąĄą╣čé ąĖ čé.ą┤.

ąĀą░čüčüą╝ąŠčéčĆąĖą╝ ą▓ąŠąĘą╝ąŠąČąĮčāčÄ čüčģąĄą╝čā ąŠčĆą│ą░ąĮąĖąĘą░čåąĖąĖ ąČąĖą▓ąŠą╣ čéčĆą░ąĮčüą╗čÅčåąĖąĖ čü ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄą╝ ą║ąŠąĮč鹥ą╣ąĮąĄčĆą░ Ogg. ąöą╗čÅ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ ą║ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą║ą╗ąĖąĄąĮčé ąĖčüą┐ąŠą╗čīąĘčāąĄčé č鹥ą│ <video>. ą¤čĆąĖ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖąĖ čŹč鹊ą│ąŠ č鹥ą│ą░ ą▒čĆą░čāąĘąĄčĆ ą┤ąĄą╗ą░ąĄčé ąĘą░ą┐čĆąŠčü GET ąĮą░ ą░ą┤čĆąĄčü čüąĄčĆą▓ąĄčĆą░:

GET / HTTP/1.1

Host: IP-address:port

Connection: keep-alive

ą¤ąŠą╗čāčćąĖą▓ ąĘą░ą┐čĆąŠčü ąŠčé ą║ą╗ąĖąĄąĮčéą░, čüąĄčĆą▓ąĄčĆ ą▓ ąŠčéą▓ąĄčé ą┤ąŠą╗ąČąĄąĮ ąŠč鹊čüą╗ą░čéčī čüą╗ąĄą┤čāčÄčēčāčÄ čüčéčĆąŠą║čā:

HTTP/1.1 200 OK

Connection: keep-alive

Cache-control: no-cache, no-store

Content-type: video/ogg

ąŚą░č鹥ą╝ čüąĄčĆą▓ąĄčĆ čüąŠąĘą┤ą░ąĄčé ąĘą░ą│ąŠą╗ąŠą▓ąŠą║ ą║ąŠąĮč鹥ą╣ąĮąĄčĆą░ Ogg ąĖ ąŠčéčüčŗą╗ą░ąĄčé ąĄą│ąŠ ą║ą╗ąĖąĄąĮčéčā. ąÜą╗ąĖąĄąĮčé ą▓ąŠčüą┐čĆąĖąĮąĖą╝ą░ąĄčé ą┐čĆąĖąĄą╝ ąĘą░ą│ąŠą╗ąŠą▓ą║ą░ ą║ą░ą║ čüąĖą│ąĮą░ą╗ ąĮą░čćą░ą╗ą░ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ. ąØą░ ąŠčüąĮąŠą▓ą░ąĮąĖąĖ ą┤ą░ąĮąĮčŗčģ ą┐čĆąĖąĮčÅč鹊ą│ąŠ ąĘą░ą│ąŠą╗ąŠą▓ą║ą░ ąŠąĮ ąĖąĮąĖčåąĖą░ą╗ąĖąĘąĖčĆčāąĄčé ą▓ąĖą┤ąĄąŠą┐ą╗ąĄąĄčĆ ąĖ ą┐ąĄčĆąĄčģąŠą┤ąĖčé ą║ ą┐čĆąĖąĄą╝čā, ą┤ąĄą║ąŠą┤ąĖčĆąŠą▓ą░ąĮąĖčÄ ąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÄ čüčéčĆą░ąĮąĖčå Ogg.

ąÆ ą┐čĆąŠčåąĄčüčüąĄ ąĘą░ą│čĆčāąĘą║ąĖ ąĖ ą┐čĆąŠąĖą│čĆčŗą▓ą░ąĮąĖčÅ ą▓ąĖą┤ąĄąŠą┐ąŠč鹊ą║ą░ ą▒čĆą░čāąĘąĄčĆ ą║ą╗ąĖąĄąĮčéą░ ą╝ąŠąČąĄčé čüąŠčģčĆą░ąĮčÅčéčī ąĘą░ą│čĆčāąČą░ąĄą╝čŗą╣ čäą░ą╣ą╗ ą▓ čüą▓ąŠąĄą╝ ą▒čāč乥čĆąĄ (ą║ąĄčłąĄ). ąÆ čŹč鹊ą╝ čüą╗čāčćą░ąĄ ą┤ąŠčüčéą░č鹊čćąĮąŠ ą┤ą╗ąĖąĮąĮą░čÅ ą▓ąĖą┤ąĄąŠčéčĆą░ąĮčüą╗čÅčåąĖčÅ ą╝ąŠąČąĄčé ą┐čĆąĖą▓ąĄčüčéąĖ ą║ ąĮąĄą┐čĆąĖčÅčéąĮčŗą╝ ą┐ąŠčüą╗ąĄą┤čüčéą▓ąĖčÅą╝ ąĮąĄčģą▓ą░čéą║ąĖ ą┤ąĖčüą║ąŠą▓ąŠą│ąŠ ą┐čĆąŠčüčéčĆą░ąĮčüčéą▓ą░. ąÜ čüčćą░čüčéčīčÄ, čüąĄčĆą▓ąĄčĆ ą╝ąŠąČąĄčé ą║ąŠąĮčéčĆąŠą╗ąĖčĆąŠą▓ą░čéčī ą▒čāč乥čĆąĖąĘą░čåąĖčÄ. ą¤čĆąĖ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖąĖ ą║ čüąĄčĆą▓ąĄčĆčā ą▒čĆą░čāąĘąĄčĆ ą║ą╗ąĖąĄąĮčéą░ ą▓ ąŠčéą▓ąĄčé ąĮą░ ąĘą░ą┐čĆąŠčü GET ą┐ąŠą╗čāčćą░ąĄčé ąĖąĮč乊čĆą╝ą░čåąĖčÄ ŌĆō ą║ą░ą║ ąĖą╝ąĄąĮąĮąŠ ąĮą░ą┤ąŠ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčī ą▒čāč乥čĆąĖąĘą░čåąĖčÄ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░:

ąøčāčćčłąĄą╣ čüčéčĆą░č鹥ą│ąĖąĄą╣ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąĄč鹊ą┤ąŠą╝ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ čÅą▓ą╗čÅąĄčéčüčÅ ą▓čŗą▒ąŠčĆ ąŠą┐čåąĖąĖ "ą▒ąĄąĘ ą▒čāč乥čĆąĖąĘą░čåąĖąĖ".

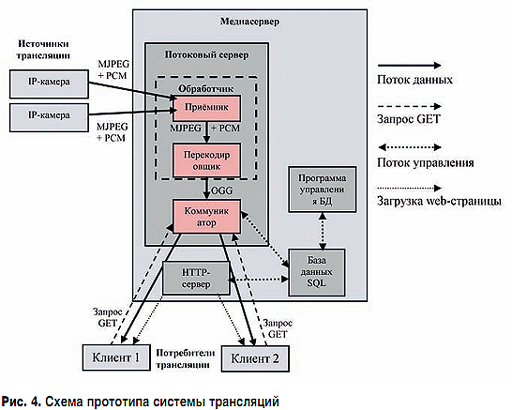

ą¤čĆąĄą┤ą╗ą░ą│ą░ąĄčéčüčÅ čüą╗ąĄą┤čāčÄčēą░čÅ čĆąĄą░ą╗ąĖąĘą░čåąĖčÅ ą┐čĆąŠč鹊čéąĖą┐ą░ čüąĖčüč鹥ą╝čŗ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąĄą┤ąĖą░ ą▓ čĆąĄą░ą╗čīąĮąŠą╝ ą▓čĆąĄą╝ąĄąĮąĖ, ąĖčüą┐ąŠą╗čīąĘčāčÄčēą░čÅ ą╝ąĄč鹊ą┤ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ. ą¤čĆąŠč鹊čéąĖą┐ čüąŠčüč鹊ąĖčé ąĖąĘ čüą╗ąĄą┤čāčÄčēąĖčģ ą║ąŠą╝ą┐ąŠąĮąĄąĮč鹊ą▓ (čüą╝. čĆąĖčü. 4):

ąÆ ą║ą░č湥čüčéą▓ąĄ ąĖčüč鹊čćąĮąĖą║ą░ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą▓ąĖą┤ąĄąŠ ąĖ ą░čāą┤ąĖąŠ ą┐čĆąĄą┤ą┐ąŠą╗ą░ą│ą░ąĄčéčüčÅ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī IP-ą║ą░ą╝ąĄčĆčŗ, ą┐ąĄčĆąĄą┤ą░čÄčēąĖąĄ ąĮą░ ą┐ąŠč鹊ą║ąŠą▓čŗą╣ čüąĄčĆą▓ąĄčĆ ą┤ą░ąĮąĮčŗąĄ ą▓ąĖą┤ąĄąŠ ą▓ č乊čĆą╝ą░č鹥 Motion JPEG [17] ąĖ ą░čāą┤ąĖąŠ ą▓ č乊čĆą╝ą░č鹥 PCM [18], ąĖąĮą║ą░ą┐čüčāą╗ąĖčĆąŠą▓ą░ąĮąĮčŗąĄ ą▓ ą┐ą░ą║ąĄčéčŗ č乊čĆą╝ą░čéą░ RTP [19]. ą¤ąŠčüą╗ąĄ ą┐čĆąĖąĄą╝ą░ ą┤ą░ąĮąĮčŗčģ čü ą║ą░ą╝ąĄčĆ ą┐ąŠč鹊ą║ąŠą▓čŗą╣ čüąĄčĆą▓ąĄčĆ ą┤ąŠą╗ąČąĄąĮ ą┐ąĄčĆąĄą║ąŠą┤ąĖčĆąŠą▓ą░čéčī ąĖčģ ą▓ č乊čĆą╝ą░čé Ogg.

ą¤čĆąĖ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖąĖ ą║ ąŠą┤ąĮąŠą╣ čéčĆą░ąĮčüą╗čÅčåąĖąĖ čüčĆą░ąĘčā ąĮąĄčüą║ąŠą╗čīą║ąĖčģ ą║ą╗ąĖąĄąĮč鹊ą▓ ą┐ą░čĆą░ą╝ąĄčéčĆčŗ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖčÅ ąĘą░ą┐čĆąŠčüą░ GET čĆą░ąĘą╗ąĖčćąĮčŗčģ ą║ą╗ąĖąĄąĮč鹊ą▓ ą╝ąŠą│čāčé ąŠčéą╗ąĖčćą░čéčīčüčÅ. ąÜąŠą╝ą╝čāąĮąĖą║ą░č鹊čĆ ą┤ąŠą╗ąČąĄąĮ čāą╝ąĄčéčī ą┐ąŠą┤čüčéčĆą░ąĖą▓ą░čéčī ąŠčéą┐čĆą░ą▓ą╗čÅąĄą╝čŗą╣ ą║ą╗ąĖąĄąĮčéčā ą┐ąŠč鹊ą║ ą╝ąĄą┤ąĖą░ą┤ą░ąĮąĮčŗčģ č乊čĆą╝ą░čéą░ Ogg ą┐ąŠą┤ ąĄą│ąŠ čéčĆąĄą▒ąŠą▓ą░ąĮąĖčÅ.

ąÆ ą┐čĆąŠčåąĄčüčüąĄ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą║ą╗ąĖąĄąĮčé ą┐ąŠčüč鹊čÅąĮąĮąŠ ąĘą░ą│čĆčāąČą░ąĄčé čäčĆą░ą│ą╝ąĄąĮčéčŗ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░. ąÆčĆąĄą╝čÅ, ąĘą░ ą║ąŠč鹊čĆąŠąĄ ą║ą╗ąĖąĄąĮčé ąĘą░ą│čĆčāąČą░ąĄčé čäčĆą░ą│ą╝ąĄąĮčé, ą┤ąŠą╗ąČąĮąŠ ą▒čŗčéčī ą╝ąĄąĮčīčłąĄ ą▓čĆąĄą╝ąĄąĮąĖ ąĄą│ąŠ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ. ąÆ ą┐čĆąŠčéąĖą▓ąĮąŠą╝ čüą╗čāčćą░ąĄ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖąĄ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą▒čāą┤ąĄčé čüąŠą┐čĆąŠą▓ąŠąČą┤ą░čéčīčüčÅ čĆčŗą▓ą║ą░ą╝ąĖ ŌĆō ąŠčüčéą░ąĮąŠą▓ą║ą░ą╝ąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ ą┤ą╗čÅ ą┤ąŠąĘą░ą│čĆčāąĘąŠą║. ąÆčĆąĄą╝čÅ ąĘą░ą│čĆčāąĘą║ąĖ čäčĆą░ą│ą╝ąĄąĮčéą░ ąĘą░ą▓ąĖčüąĖčé ąŠčé ą┐čĆąŠą┐čāčüą║ąĮąŠą╣ čüą┐ąŠčüąŠą▒ąĮąŠčüčéąĖ ą║ą░ąĮą░ą╗ą░ čüą▓čÅąĘąĖ ąĖ ą║ą░č湥čüčéą▓ą░ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ ąĖ ąĘą▓čāą║ą░ ą▓ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ąĄ. ą¦ąĄą╝ ą╗čāčćčłąĄ ą║ą░č湥čüčéą▓ąŠ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ, č鹥ą╝ ą▒ąŠą╗čīčłąĄ čĆą░ąĘą╝ąĄčĆ ą║ą░ąČą┤ąŠą│ąŠ ą║ą░ą┤čĆą░ ąĖ, čüą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīąĮąŠ, ą▓čüąĄą│ąŠ ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ą░. ą×ą▒ąĄčüą┐ąĄčćąĖčéčī ą┐ą╗ą░ą▓ąĮąŠčüčéčī ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąŠąČąĮąŠ ą┤ą▓čāą╝čÅ čüą┐ąŠčüąŠą▒ą░ą╝ąĖ ŌĆō ą╗ąĖą▒ąŠ čāą▓ąĄą╗ąĖčćąĖčéčī ą┐čĆąŠą┐čāčüą║ąĮčāčÄ čüą┐ąŠčüąŠą▒ąĮąŠčüčéčī ą║ą░ąĮą░ą╗ą░ čüą▓čÅąĘąĖ, ą╗ąĖą▒ąŠ čāčģčāą┤čłąĖčéčī ą║ą░č湥čüčéą▓ąŠ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ ąĖ ąĘą▓čāą║ą░, čāą╝ąĄąĮčīčłąĖą▓ č鹥ą╝ čüą░ą╝čŗą╝ čĆą░ąĘą╝ąĄčĆ ąĘą░ą│čĆčāąČą░ąĄą╝čŗčģ čäčĆą░ą│ą╝ąĄąĮč鹊ą▓.

ąśčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą╝ąĄč鹊ą┤ą░ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░, čĆą░čüčüą╝ą░čéčĆąĖą▓ą░ąĄą╝ąŠą│ąŠ ą║ą░ą║ čäą░ą╣ą╗, ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąŠčĆą│ą░ąĮąĖąĘąŠą▓ą░čéčī čéčĆą░ąĮčüą╗čÅčåąĖčÄ ą╝ąĄą┤ąĖą░ ą▓ čĆąĄą░ą╗čīąĮąŠą╝ ą▓čĆąĄą╝ąĄąĮąĖ. ąÆ ą║ą░č湥čüčéą▓ąĄ ą║ąŠąĮč鹥ą╣ąĮąĄčĆą░ ą╝ąĄą┤ąĖą░ą┐ąŠč鹊ą║ą░ ą┐čĆąĄą┤ą╗ą░ą│ą░ąĄčéčüčÅ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī č乊čĆą╝ą░čé Ogg, ą║ąŠč鹊čĆčŗą╣ ą┐ąŠ čüą▓ąŠąĄą╣ čüčāčéąĖ čÅą▓ą╗čÅąĄčéčüčÅ ą┐ąŠč鹊ą║ąŠą▓čŗą╝ ąĖ ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ ą║ą╗ąĖąĄąĮčéą░ą╝ ą┐ąŠą┤ą║ą╗čÄčćą░čéčīčüčÅ ą║ čāąČąĄ ą▓ąĄą┤čāčēąĄą╣čüčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą▓ ą┐čĆąŠąĖąĘą▓ąŠą╗čīąĮčŗą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ.

ąÆ čüčĆą░ą▓ąĮąĄąĮąĖąĖ čü ąŠčüąĮąŠą▓ąĮčŗą╝ąĖ č鹥čģąĮąŠą╗ąŠą│ąĖčÅą╝ąĖ ą┐ąŠč鹊ą║ąŠą▓ąŠą│ąŠ ą▓ąĄčēą░ąĮąĖčÅ (Apple HLS, HDS, Microsoft SS, MPEG-DASH), ą┐čĆąĄą┤ą╗ą░ą│ą░ąĄą╝ą░čÅ čĆąĄą░ą╗ąĖąĘą░čåąĖčÅ čüąĖčüč鹥ą╝čŗ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ą╝ąĄč鹊ą┤ąŠą╝ ąŠą┐ąĄčĆąĄąČą░čÄčēąĄą╣ ąĘą░ą│čĆčāąĘą║ąĖ ąŠą▒ą╗ą░ą┤ą░ąĄčé ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮčŗą╝ąĖ ą┤ąŠčüč鹊ąĖąĮčüčéą▓ą░ą╝ąĖ. ąĪąĄčĆą▓ąĄčĆčā ąĮąĄčé ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéąĖ čüąŠąĘą┤ą░ą▓ą░čéčī ą╝ą░ąĮąĖč乥čüčéčŗ ąĖ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčī ą┐čĆąĄą┤ą▓ą░čĆąĖč鹥ą╗čīąĮčāčÄ čĆą░ąĘą▒ąĖą▓ą║čā ą╝ąĄą┤ąĖą░čäą░ą╣ą╗ąŠą▓ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ąĮą░ čäčĆą░ą│ą╝ąĄąĮčéčŗ. ą£ąĄą┤ąĖą░čäą░ą╣ą╗ ąČąĖą▓ąŠą╣ čéčĆą░ąĮčüą╗čÅčåąĖąĖ č乊čĆą╝ą░čéą░ Ogg ą┐ąĄčĆąĄą┤ą░ąĄčéčüčÅ ą║ą░ą║ ąĄčüčéčī. ąöą╗čÅ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ąĮą░ čüč鹊čĆąŠąĮąĄ ą║ą╗ąĖąĄąĮčéą░ ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ č鹥ą│ <video> ą▒ąĄąĘ ą┐čĆąĖą▓ą╗ąĄč湥ąĮąĖčÅ čüč鹊čĆąŠąĮąĮąĖčģ ą┐ą╗ą░ą│ąĖąĮąŠą▓ ąĖ ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčŗčģ čĆą░čüčłąĖčĆąĄąĮąĖą╣ ą▒čĆą░čāąĘąĄčĆą░. ą×čéčüčāčéčüčéą▓ąĖąĄ ąŠą│čĆą░ąĮąĖč湥ąĮąĖčÅ ąĮą░ čĆą░ąĘą╝ąĄčĆ čäčĆą░ą│ą╝ąĄąĮčéą░ čüčéčĆą░ąĮąĖčåčŗ Ogg ą┐ąŠąĘą▓ąŠą╗čÅąĄčé čāą╝ąĄąĮčīčłąĖčéčī ąĘą░ą┤ąĄčƹȹ║čā ą▓ąĄčēą░ąĮąĖčÅ ą┤ąŠ ą┐čĆąĖąĄą╝ą╗ąĄą╝ąŠą╣ ą▓ąĄą╗ąĖčćąĖąĮčŗ. ą×ąČąĖą┤ą░ąĄą╝ą░čÅ ąĘą░ą┤ąĄčƹȹ║ą░ ą▓čĆąĄą╝ąĄąĮąĖ ą▓ąŠčüą┐čĆąŠąĖąĘą▓ąĄą┤ąĄąĮąĖčÅ čéčĆą░ąĮčüą╗čÅčåąĖąĖ ąĮą░ ą║ą╗ąĖąĄąĮč鹥 čüąŠčüčéą░ą▓ą╗čÅąĄčé ą╝ąĄąĮąĄąĄ ąŠą┤ąĮąŠą╣ čüąĄą║čāąĮą┤čŗ. ą×čéčüčāčéčüčéą▓ąĖąĄ ą┐ą░č鹥ąĮčéąĮčŗčģ ąĖą╗ąĖ ą╗ąĖčåąĄąĮąĘąĖąŠąĮąĮčŗčģ ąŠą│čĆą░ąĮąĖč湥ąĮąĖą╣ ąĮą░ č乊čĆą╝ą░čé Ogg ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ą┐čĆąĄą┤ą╗ą░ą│ą░ąĄą╝čāčÄ č鹥čģąĮąŠą╗ąŠą│ąĖčÄ ą▓ čāąĘą║ąĖčģ čüąĄą│ą╝ąĄąĮčéą░čģ (ąĮą░ ą┐čĆąĄą┤ą┐čĆąĖčÅčéąĖąĖ, ą┐čĆąŠąĖąĘą▓ąŠą┤čüčéą▓ąĄ ąĖ čé.ą┤.)n.

ąøąĖč鹥čĆą░čéčāčĆą░

ą×ą┐čāą▒ą╗ąĖą║ąŠą▓ą░ąĮąŠ: ą¢čāčĆąĮą░ą╗ "ąóąĄčģąĮąŠą╗ąŠą│ąĖąĖ ąĖ čüčĆąĄą┤čüčéą▓ą░ čüą▓čÅąĘąĖ" #5, 2016

ą¤ąŠčüąĄčēąĄąĮąĖą╣: 4473

ąÉą▓č鹊čĆ

| |||

ąÉą▓č鹊čĆ

| |||

ąÆ čĆčāą▒čĆąĖą║čā "ąĀąĄčłąĄąĮąĖčÅ ąŠą┐ąĄčĆą░č鹊čĆčüą║ąŠą│ąŠ ą║ą╗ą░čüčüą░" | ąÜ čüą┐ąĖčüą║čā čĆčāą▒čĆąĖą║ | ąÜ čüą┐ąĖčüą║čā ą░ą▓č鹊čĆąŠą▓ | ąÜ čüą┐ąĖčüą║čā ą┐čāą▒ą╗ąĖą║ą░čåąĖą╣