ąÆ čĆčāą▒čĆąĖą║čā "ą”ąĄąĮčéčĆčŗ ąŠą▒čĆą░ą▒ąŠčéą║ąĖ ą┤ą░ąĮąĮčŗčģ (ą”ą×ąö)" | ąÜ čüą┐ąĖčüą║čā čĆčāą▒čĆąĖą║ | ąÜ čüą┐ąĖčüą║čā ą░ą▓č鹊čĆąŠą▓ | ąÜ čüą┐ąĖčüą║čā ą┐čāą▒ą╗ąĖą║ą░čåąĖą╣

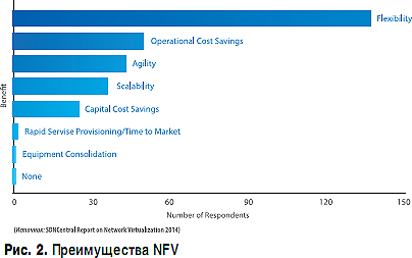

ąĀąŠčüčé čćąĖčüą╗ą░ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ ąĖ ąĖąĮč鹥ą│čĆą░čåąĖčÅ ąŠą▒ą╗ą░čćąĮčŗčģ ą┐ą╗ą░čéč乊čĆą╝ ą╝ąĄąĮčÅčÄčé ą┐čĆąĖą▓čŗčćąĮčŗą╣ ąŠą▒ą╗ąĖą║ ąĖ čĆą░ą▒ąŠčéčā IT-ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ ąĖ ą”ą×ąöąŠą▓ ą▓ čćą░čüčéąĮąŠčüčéąĖ. ąśąĮčäčĆą░čüčéčĆčāą║čéčāčĆą░ ą”ą×ąöąŠą▓ ąĖ ą┐čĆąŠą│čĆą░ą╝ą╝ąĮčŗčģ ą┐ą╗ą░čéč乊čĆą╝ čüąŠą▓ąĄčĆčłąĄąĮčüčéą▓čāąĄčéčüčÅ. ą¤ąŠčÅą▓ą╗čÅčÄčéčüčÅ ąĮąŠą▓čŗąĄ ą║ąŠąĮčåąĄą┐čåąĖąĖ ą┐čĆąŠą│čĆą░ą╝ą╝ąĮąŠ-ąŠą┐čĆąĄą┤ąĄą╗čÅąĄą╝ąŠą│ąŠ ą”ą×ąöą░ (Software-defined data center, SDDC). ąöą╗čÅ čŹč鹊ą│ąŠ ąĮąĄąŠą▒čģąŠą┤ąĖą╝čŗ čüąŠą▓čĆąĄą╝ąĄąĮąĮčŗąĄ ą┐ąŠą┤čģąŠą┤čŗ ą║ ą┐čĆąŠąĄą║čéąĖčĆąŠą▓ą░ąĮąĖčÄ ąĖ čüčéčĆąŠąĖč鹥ą╗čīčüčéą▓čā ą”ą×ąöąŠą▓ ŌĆō ąĮąŠą▓ą░čÅ čäąĖąĘąĖč湥čüą║ą░čÅ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆą░ (菹╗ąĄą║čéčĆąŠą┐ąĖčéą░ąĮąĖąĄ, čĆąĄąĘąĄčĆą▓ąĖčĆąŠą▓ą░ąĮąĖąĄ, ąŠčģą╗ą░ąČą┤ąĄąĮąĖąĄ, ą┐ąŠąČą░čĆąŠčéčāčłąĄąĮąĖąĄ ąĖ čé.ą┤.).

The growing number of applications and the integration of cloud platforms change the familiar face and the work of IT-infrastructure and data centers in particular. Data center infrastructure and software platforms improved. There are new concepts of application-defined data center (Software-defined data center, SDDC). This requires modern approaches to the design and construction of the data center - a new physical infrastructure (power, redundancy, cooling, fire protection, etc.).

ąĪ ąŠą┤ąĮąŠą╣ čüč鹊čĆąŠąĮčŗ, ą╝čŗ (ąĀąŠčüčüąĖčÅ) ą▓ ąĮą░čćą░ą╗ąĄ ąĮčāą╗ąĄą▓čŗčģ čü ą│ąŠą╗ąŠą▓ąŠą╣ ąŠą║čāąĮčāą╗ąĖčüčī ą▓ ą”ą×ąöąŠčüčéčĆąŠąĄąĮąĖąĄ. ą£ąŠąČąĮąŠ čüą║ą░ąĘą░čéčī, ąĖą╝ąĄą╗ ą╝ąĄčüč鹊 čüą░ą╝čŗą╣ ąĮą░čüč鹊čÅčēąĖą╣ ą▒čāą╝ čüčéčĆąŠąĖč鹥ą╗čīčüčéą▓ą░ ą┤ą░čéą░-čåąĄąĮčéčĆąŠą▓. ąĪ ą┤čĆčāą│ąŠą╣ čüč鹊čĆąŠąĮčŗ, ą▓ č鹊čé ą┐ąĄčĆąĖąŠą┤ ąĮąĖą║č鹊 ąĮąĄ ąĘą░ą┤čāą╝čŗą▓ą░ą╗čüčÅ ąŠ č鹊ą╝, čćč鹊 čüčĆąŠą║ ąČąĖąĘąĮąĖ ą”ą×ąöą░ ą┤ąŠą╗ąČąĄąĮ ąĮą░ą╝ąĮąŠą│ąŠ ą┐čĆąĄą▓čŗčłą░čéčī čéą░ą║ąŠą▓ąŠą╣ čā čĆą░ąĘą╝ąĄčēą░ąĄą╝ąŠą│ąŠ ą▓ ąĮąĄą╝ čüąĄčĆą▓ąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ. ąśąĘą╝ąĄąĮąĄąĮąĖčÅ ąĖąĮąČąĄąĮąĄčĆąĮąŠą╣ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ ą”ą×ąöą░ ą┐čĆąŠąĖčüčģąŠą┤čÅčé ą╝ąĄąĮąĄąĄ ą┤ąĖąĮą░ą╝ąĖčćąĮąŠ ą┐ąŠ čüčĆą░ą▓ąĮąĄąĮąĖčÄ čü ąĖąĘą╝ąĄąĮąĄąĮąĖčÅą╝ąĖ ą░čĆčģąĖč鹥ą║čéčāčĆčŗ čüąĄčĆą▓ąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ. ąÆ čĆąĄąĘčāą╗čīčéą░č鹥 ąĮą░ čüąĄą│ąŠą┤ąĮčÅčłąĮąĖą╣ ą┤ąĄąĮčī ą▓ ąĀąŠčüčüąĖąĖ čĆą░ąĘą╝ąĄčēąĄąĮąŠ ą▒ąŠą╗čīčłąŠąĄ ą║ąŠą╗ąĖč湥čüčéą▓ąŠ ą”ą×ąöąŠą▓, ą┐ąŠčüčéčĆąŠąĄąĮąĮčŗčģ čü čāč湥č鹊ą╝ ą┐čĆąŠą│ąĮąŠąĘą░ ąĮą░ą┐ąŠą╗ąĮčÅąĄą╝ąŠčüčéąĖ čüąĄčĆą▓ąĄčĆąĮčŗą╝ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄą╝, ą┐čĆąŠą┤ąŠą╗ąČąĖč鹥ą╗čīąĮąŠčüčéčī ąČąĖąĘąĮąĖ ą║ąŠč鹊čĆąŠą│ąŠ ą▓ čüčĆąĄą┤ąĮąĄą╝ čüąŠčüčéą░ą▓ą╗čÅąĄčé ąĮąĄ ą▒ąŠą╗ąĄąĄ 5 ą╗ąĄčé.

ą¤čĆąĄąČą┤ąĄ, ąĮą░ą┐čĆąĖą╝ąĄčĆ, ą”ą×ąöčŗ ą┐čĆąĖ ą┐čĆąŠąĄą║čéąĖčĆąŠą▓ą░ąĮąĖąĖ čĆą░čüčüčćąĖčéčŗą▓ą░ą╗ąĖčüčī ąĮą░ čāčüčéą░ąĮąŠą▓ą║čā ą▓ ąĮąĖčģ ą╝ąŠąĮąŠą▒ą╗ąŠčćąĮčŗčģ čüąĄčĆą▓ąĄčĆąĮčŗčģ čüąĖčüč鹥ą╝ ą║ą╗ą░čüčüą░ Hi-End, čéą░ą║ąĖčģ ą║ą░ą║ SUN Fire 25K ąĖ ąĖą╝ ą┐ąŠą┤ąŠą▒ąĮčŗčģ. ąØą░ čüąĄą│ąŠą┤ąĮčÅčłąĮąĖą╣ ą┤ąĄąĮčī ą▓čüąĄ čŹčéąĖ ą│čĆąŠą╝ąŠąĘą┤ą║ąĖąĄ ą╝ąŠąĮąŠą▒ą╗ąŠą║ąĖ ąĮą░ ą▒ą░ąĘąĄ ą┐čĆąŠčåąĄčüčüąŠčĆąŠą▓ RISC-ą░čĆčģąĖč鹥ą║čéčāčĆčŗ ą┐čĆą░ą║čéąĖč湥čüą║ąĖ ąĖčüč湥ąĘą╗ąĖ čü čĆčŗąĮą║ą░ ŌĆō ą▓čüąĄ ą┐ąĄčĆąĄčłą╗ąĖ ąĮą░ ą░čĆčģąĖč鹥ą║čéčāčĆčā čģ86. ąÆąŠąĘąĮąĖą║ą╗ąŠ ąĖąĘąŠą▒ąĖą╗ąĖąĄ čüąĄčĆą▓ąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ ą▓ ą║ąŠą╝ą┐ą░ą║čéąĮąŠą╝ ąĖčüą┐ąŠą╗ąĮąĄąĮąĖąĖ: ą▒ą╗ąĄą╣ą┤-čüąĄčĆą▓ąĄčĆčŗ, čüąĄčĆą▓ąĄčĆčŗ ą▓čŗčüąŠč鹊ą╣ 1ŌĆō2U. ąś, ąĄčüą╗ąĖ ą┐ąŠ čüčĆą░ą▓ąĮąĄąĮąĖčÄ čü ą╝ąŠąĮąŠą▒ą╗ąŠą║ąŠą╝, čüčāą╝ą╝ą░čĆąĮąŠąĄ ą┐ąŠčéčĆąĄą▒ą╗ąĄąĮąĖąĄ 菹╗ąĄą║čéčĆąŠčŹąĮąĄčĆą│ąĖąĖ ą▓ čĆą░čüč湥č鹥 ąĮą░ ąŠą┤ąĮčā čüč鹊ą╣ą║čā ąĮąĄ ąĖąĘą╝ąĄąĮąĖą╗ąŠčüčī, č鹊 ąŠčģą╗ą░ąČą┤ąĄąĮąĖąĄ čāčüčéą░ąĮą░ą▓ą╗ąĖą▓ą░ąĄą╝ąŠą│ąŠ ą▓ čüč鹊ą╣ą║čā ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ ą┤ąŠą╗ąČąĮąŠ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖčéčīčüčÅ ąĖąĮą░č湥. ąÆ čüąŠą┐čĆąŠą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠą╣ ą┤ąŠą║čāą╝ąĄąĮčéą░čåąĖčÅ ą║ RISC-čüąĄčĆą▓ąĄčĆą░ą╝ SUN Microsystems ąŠčéą┤ąĄą╗čīąĮąŠ ąŠą│ąŠą▓ą░čĆąĖą▓ą░ą╗ąŠčüčī čéčĆąĄą▒ąŠą▓ą░ąĮąĖąĄ ąŠą▒ąĄčüą┐ąĄčćąĖčéčī ą┐ąŠą┤ą░čćčā ą▓ąĄąĮčéąĖą╗čÅčåąĖąŠąĮąĮąŠą│ąŠ ą▓ąŠąĘą┤čāčģą░ ą▓ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠą╝ ąŠą▒čŖąĄą╝ąĄ č湥čĆąĄąĘ ąŠčéą▓ąĄčĆčüčéąĖčÅ ą▓ čäą░ą╗čīčłą┐ąŠą╗ąĄ. ąØąŠą▓čŗą╣ č乊čĆą╝-čäą░ą║č鹊čĆ čüąĄčĆą▓ąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ, ą║ą░ą║ ą╝ąĖąĮąĖą╝čāą╝, čéčĆąĄą▒čāąĄčé ąĖąĮąŠą╣ ą║ąŠąĮčäąĖą│čāčĆą░čåąĖąĖ ą▓ąĄąĮčéąĖą╗ąĖčĆąŠą▓ą░ąĮąĖčÅ ąĖ ą▓čŗą▓ąŠą┤ą░ č鹥ą┐ą╗ą░ ąĖąĘ čüč鹊ą╣ą║ąĖ. ąöą░ąĮąĮąŠąĄ ąŠą▒čüč鹊čÅč鹥ą╗čīčüčéą▓ąŠ ąĮą░čĆčÅą┤čā čüąŠ ą╝ąĮąŠą│ąĖą╝ąĖ ą┤čĆčāą│ąĖą╝ąĖ ą┐čĆąĖą▓ąŠą┤ąĖčé ą║ ąĮąĄą┤ąŠąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÄ čüąĄčĆą▓ąĄčĆąĮčŗčģ ą┐ą╗ąŠčēą░ą┤ąĄą╣ ąĖ ąĖąĮąČąĄąĮąĄčĆąĮąŠą╣ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ ą”ą×ąöą░. ąśčüą┐čĆą░ą▓ąĖčéčī čüą╗ąŠąČąĖą▓čłčāčÄčüčÅ čüąĖčéčāą░čåąĖčÄ, ą║ čüąŠąČą░ą╗ąĄąĮąĖčÄ, ąĮąĄ ą┐čĆąĄą┤čüčéą░ą▓ą╗čÅąĄčéčüčÅ ą▓ąŠąĘą╝ąŠąČąĮčŗą╝.

ą¤ąĄčĆą▓ąŠąĄ, čćč鹊 ą┐čĆąĖčģąŠą┤ąĖčé ąĮą░ čāą╝, ŌĆō ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ ą┐ąŠčüčéčĆąŠąĖčéčī ąĮąŠą▓čŗąĄ ą”ą×ąöčŗ, ąŠą┐čéąĖą╝ą░ą╗čīąĮąŠ ą┐čĆąĖčüą┐ąŠčüąŠą▒ą╗ąĄąĮąĮčŗąĄ ą║ ąĮąŠą▓ąĄą╣čłąĄą╣ čüąĄčĆą▓ąĄčĆąĮąŠą╣ ą░čĆčģąĖč鹥ą║čéčāčĆąĄ. ą¤ąŠčüčéčĆąŠąĖą▓ čüąŠą▓čĆąĄą╝ąĄąĮąĮčŗą╣ ą”ą×ąö, ąĄą│ąŠ ą▓ą╗ą░ą┤ąĄą╗ąĄčå čäą░ą║čéąĖč湥čüą║ąĖ ąŠą║ą░ąĘčŗą▓ą░ąĄčéčüčÅ ąĮą░ "čĆčŗąĮą║ąĄ ą┐čĆąŠą┤ą░ą▓čåą░", čé.ąĄ. čā ąĮąĄą│ąŠ ąĮąĄčé ą┐čĆąŠą▒ą╗ąĄą╝ čüąŠ čüą▒čŗč鹊ą╝ čüąĄčĆą▓ąĄčĆąĮčŗčģ ą┐ą╗ąŠčēą░ą┤ąĄą╣. ąÆą╗ą░ą┤ąĄą╗čīčåčŗ ąĮąŠą▓ąŠą│ąŠ čüąĄčĆą▓ąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ čģąŠčéčÅčé čĆą░ąĘą╝ąĄčüčéąĖčéčī ąĄą│ąŠ ąĮą░ąĖą▒ąŠą╗ąĄąĄ čŹčäč乥ą║čéąĖą▓ąĮąŠ, ą░ ą▓ čāąĮą░čüą╗ąĄą┤ąŠą▓ą░ąĮąĮčŗčģ ą”ą×ąöą░čģ čŹč鹊 čüą┤ąĄą╗ą░čéčī ąĮąĄą▓ąŠąĘą╝ąŠąČąĮąŠ. ąĀąĄąĘčāą╗čīčéą░čé: čüąĄčĆą▓ąĄčĆąĮąŠąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ ą┐ąĄčĆąĄąĄąĘąČą░ąĄčé ąĮą░ ąĮąŠą▓ąŠąĄ ą╝ąĄčüč鹊, ą┐ąŠą║ąĖą┤ą░čÅ čāąĮą░čüą╗ąĄą┤ąŠą▓ą░ąĮąĮčŗąĄ ą”ą×ąöčŗ, čéą░ą║ąĖą╝ ąŠą▒čĆą░ąĘąŠą╝, čāčéąĖą╗ąĖąĘą░čåąĖčÅ ą┐ąŠčüą╗ąĄą┤ąĮąĖčģ čüąĮąĖąČą░ąĄčéčüčÅ ąĄčēąĄ čüąĖą╗čīąĮąĄąĄ. ą×ą┤ąĮą░ą║ąŠ ąĖąĘ-ąĘą░ 菹║ąŠąĮąŠą╝ąĖč湥čüą║ąŠą╣ čüčéą░ą│ąĮą░čåąĖąĖ ąĮąŠą▓čŗčģ ą”ą×ąöąŠą▓ ą┐ąŠą║ą░ ą┐ąŠčüčéčĆąŠąĄąĮąŠ čüąŠą▓čüąĄą╝ ąĮąĄą╝ąĮąŠą│ąŠ, ąĖ ąŠąĮąĖ čāąČąĄ ąĮą░ 100% ąĘą░ą┐ąŠą╗ąĮąĄąĮčŗ.

ąóąĄą╝ čüą░ą╝čŗą╝ ą▓ą╗ą░ą┤ąĄą╗čīčåčŗ čāąĮą░čüą╗ąĄą┤ąŠą▓ą░ąĮąĮčŗčģ ą”ą×ąöąŠą▓ ąŠą║ą░ąĘą░ą╗ąĖčüčī ą▓ ą▓ąĄčüčīą╝ą░ ą┐ą╗ą░č湥ą▓ąĮąŠą╣ čüąĖčéčāą░čåąĖąĖ ŌĆō ąŠčé ąĮąĖčģ čāčģąŠą┤čÅčé ą║ą╗ąĖąĄąĮčéčŗ, ąĖ ą▓ č鹊 ą▓čĆąĄą╝čÅ ą║ą░ą║ ą▓ą╗ąŠąČąĄąĮąĮčŗąĄ ą▓ ą”ą×ąö ąĖąĮą▓ąĄčüčéąĖčåąĖąĖ, ą┐ąŠ-čģąŠčĆąŠčłąĄą╝čā, ą┤ąŠą╗ąČąĮčŗ ą▒čŗ ąĄčēąĄ čĆą░ą▒ąŠčéą░čéčī, čüąŠ čüąĮąĖąČąĄąĮąĖąĄą╝ čāčéąĖą╗ąĖąĘą░čåąĖąĖ ą┤ąŠčģąŠą┤čŗ ąŠčé 菹║čüą┐ą╗čāą░čéą░čåąĖąĖ čāąĮą░čüą╗ąĄą┤ąŠą▓ą░ąĮąĮąŠą│ąŠ ą┤ą░čéą░-čåąĄąĮčéčĆą░ ą┐ą░ą┤ą░čÄčé.

ąöąĄą╗ąŠ ą▓ č鹊ą╝, čćč鹊 čéą░ą║ąĖąĄ ą”ą×ąöčŗ ąŠčüąĮą░čēąĄąĮčŗ ąĖąĮąČąĄąĮąĄčĆąĮčŗą╝ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄą╝, ąĮąĄ ą┐čĆąĖčüą┐ąŠčüąŠą▒ą╗ąĄąĮąĮčŗą╝ ą┤ą╗čÅ ąŠą▒čüą╗čāąČąĖą▓ą░ąĮąĖčÅ čüąŠą▓čĆąĄą╝ąĄąĮąĮčŗčģ čüąĄčĆą▓ąĄčĆąŠą▓. ąÆ ą┐čĆąĖąĮčåąĖą┐ąĄ, ąŠąĮąĖ ą╝ąŠą│čāčé ą▒čŗčéčī čĆą░ąĘą╝ąĄčēąĄąĮčŗ ąĖ ą▓ ą”ą×ąöąĄ "čüčéą░čĆąŠą│ąŠ ąŠą▒čĆą░ąĘčåą░", ąĮąŠ čŹč鹊 ąĮąĄąĖąĘą▒ąĄąČąĮąŠ ą▓čŗąĘąŠą▓ąĄčé ą┤ąĄą│čĆą░ą┤ą░čåąĖčÄ čŹčäč乥ą║čéąĖą▓ąĮąŠčüčéąĖ ąĖčģ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ, čĆą░ą▓ąĮąŠ ą║ą░ą║ ąĖ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ąĖąĮąČąĄąĮąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ. ąĢčüą╗ąĖ ą▓ čāąĮą░čüą╗ąĄą┤ąŠą▓ą░ąĮąĮąŠą╝ ą”ą×ąöąĄ ąĮą░ ą┐ą╗ąŠčēą░ą┤ąĖ ą▓ 4 ą╝2, ą║ ą┐čĆąĖą╝ąĄčĆčā, čĆą░ąĘą╝ąĄčēą░ą╗čüčÅ ąŠą┤ąĖąĮ čüąĄčĆą▓ąĄčĆ ą║ą╗ą░čüčüą░ High-End ą▓čŗčüąŠč鹊ą╣ 42 ą┤čÄą╣ą╝ą░, ą┐ąŠčéčĆąĄą▒ą╗čÅą▓čłąĖą╣ 20 ą║ąÆčé 菹╗ąĄą║čéčĆąŠčŹąĮąĄčĆą│ąĖąĖ ąĖ čéčĆąĄą▒čāčÄčēąĖą╣ čüąŠąŠčéą▓ąĄčéčüčéą▓čāčÄčēąĄą│ąŠ č鹥ą┐ą╗ąŠąŠčéą▓ąĄą┤ąĄąĮąĖčÅ, č鹊 ąĮą░ ąĄą│ąŠ ą╝ąĄčüč鹊 čüčéą░ą▓ąĖčéčüčÅ čüč鹊ą╣ą║ą░ čü čéčĆąĄą╝čÅ ą║ąŠčƹʹĖąĮą░ą╝ąĖ ą▒ą╗ąĄą╣ą┤-čüąĄčĆą▓ąĄčĆąŠą▓ čģ86, ą║ą░ąČą┤ą░čÅ ąĖąĘ ą║ąŠč鹊čĆčŗčģ ą▓čŗą┤ąĄą╗čÅąĄčé ą┤ąŠ 15 ą║ąÆčé č鹥ą┐ą╗ą░. ąØą░ čüą░ą╝ąŠą╝ ą┤ąĄą╗ąĄ čŹč鹊 ąŠąĘąĮą░čćą░ąĄčé, čćč鹊 ąĮą░ čŹč鹊ą╣ ą┐ą╗ąŠčēą░ą┤ąĖ ą▓ čüčéą░ąĮą┤ą░čĆčéąĮąŠą╣ čüč鹊ą╣ą║ąĄ ą╝ąŠąČąĮąŠ čĆą░ąĘą╝ąĄčüčéąĖčéčī č鹊ą╗čīą║ąŠ ą┤ą▓ąĄ ą▒ą╗ąĄą╣ą┤-ą║ąŠčƹʹĖąĮčŗ, čĆą░ą▒ąŠčéą░čÄčēąĖąĄ čü ąĮąĄą┐ąŠą╗ąĮąŠą╣ ąĮą░ą│čĆčāąĘą║ąŠą╣. ąóčĆąĄčéčī ąČąĄ čüč鹊ąĄčćąĮąŠą│ąŠ "ą▒ą╗ąĄą╣ą┤-ą┐čĆąŠčüčéčĆą░ąĮčüčéą▓ą░" ąŠčüčéą░ąĮąĄčéčüčÅ ąĮąĄąĘą░ą┐ąŠą╗ąĮąĄąĮąĮčŗą╝. ąÆąŠąĘąĮąĖą║ą░ąĄčé, čü ąŠą┤ąĮąŠą╣ čüč鹊čĆąŠąĮčŗ, čéą░ą║ ąĮą░ąĘčŗą▓ą░ąĄą╝ą░čÅ "čäčĆą░ą│ą╝ąĄąĮčéą░čåąĖčÅ čÄąĮąĖč鹊ą▓", čü ą┤čĆčāą│ąŠą╣ ŌĆō čüąĄčĆą▓ąĄčĆčŗ ą┐čĆąĖčģąŠą┤ąĖčéčüčÅ ąĮąĄą┤ąŠą│čĆčāąČą░čéčī, čćč鹊ą▒čŗ ą▓čŗą┤ąĄčƹȹĖą▓ą░čéčī ą┐čĆąŠąĄą║čéąĮčŗąĄ ą┐ą░čĆą░ą╝ąĄčéčĆčŗ 菹║čüą┐ą╗čāą░čéą░čåąĖąĖ čüąĖčüč鹥ą╝ 菹╗ąĄą║čéčĆąŠčüąĮą░ą▒ąČąĄąĮąĖčÅ ąĖ ą▓ąĄąĮčéąĖą╗čÅčåąĖąĖ. ąÆ ą╝ą░čüčłčéą░ą▒ą░čģ ą”ą×ąöą░ čŹč鹊 ą┐čĆąĖą▓ąŠą┤ąĖčé ą║ ą┐ą░ą┤ąĄąĮąĖčÄ čāčéąĖą╗ąĖąĘą░čåąĖąĖ čüąŠ ą▓čüąĄą╝ąĖ ą▓čŗč鹥ą║ą░čÄčēąĖą╝ąĖ ą┐ąŠčüą╗ąĄą┤čüčéą▓ąĖčÅą╝ąĖ.

ąÆ č鹊 ą▓čĆąĄą╝čÅ ą║ą░ą║ čüąĄčĆą▓ąĄčĆąĮąŠąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ ą╝ąĄąĮčÅąĄčéčüčÅ ąŠč湥ąĮčī ą▒čŗčüčéčĆąŠ, ąĖąĮąČąĄąĮąĄčĆąĮąŠąĄ ŌĆō ąĖą╝ąĄąĄčé č鹥ąĮą┤ąĄąĮčåąĖčÄ ą║ ą▒ąŠą╗ąĄąĄ ą╝ąĄą┤ą╗ąĄąĮąĮąŠą╝čā ąĖąĘą╝ąĄąĮąĄąĮąĖčÄ, ąŠąĮąŠ ą▒ąŠą╗ąĄąĄ ą║ąŠąĮčüąĄčĆą▓ą░čéąĖą▓ąĮąŠ. ąÜą░ą║ čéą░ą║ąŠą▓čŗčģ, čŹčéą░ą┐ąŠą▓ ą╝ąŠą┤ąĄčĆąĮąĖąĘą░čåąĖąĖ čüąĖčüč鹥ą╝ ąĖąĮąČąĄąĮąĄčĆąĮąŠą│ąŠ ąŠą▒ąĄčüą┐ąĄč湥ąĮąĖčÅ ąĮąĄą╝ąĮąŠą│ąŠ. ąÆąŠąĘčīą╝ąĄą╝, ąĮą░ą┐čĆąĖą╝ąĄčĆ, ąŠčģą╗ą░ąČą┤ą░čÄčēąĄąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ, ą╝ąŠą┤ąĄčĆąĮąĖąĘą░čåąĖčÅ ą║ąŠč鹊čĆąŠą│ąŠ ąĮą░ą┐čĆą░ą▓ą╗ąĄąĮą░ ąĮą░ čüąĮąĖąČąĄąĮąĖąĄ ą║ąŠčŹčäčäąĖčåąĖąĄąĮčéą░ PUE ŌĆō ą▓čüčéčĆąŠąĄąĮąĮčŗąĄ ą▓ čäą░ą╗čīčłą┐ąŠą╗ ąĖą╗ąĖ ą▓ąĮčāčéčĆąĖčĆčÅą┤ąĮčŗąĄ ą║ąŠąĮą┤ąĖčåąĖąŠąĮąĄčĆčŗ, ąĖąĘąŠą╗ąĖčĆąŠą▓ą░ąĮąĮčŗąĄ čģąŠą╗ąŠą┤ąĮčŗąĄ ąĖ ą│ąŠčĆčÅčćąĖąĄ ą║ąŠčĆąĖą┤ąŠčĆčŗ, čäčĆąĖą║čāą╗ąĖąĮą│ ŌĆō ą▓ąŠčé, ą┐ąŠąČą░ą╗čāą╣, ąĖ ą▓čüąĄ ą▓ą░čĆąĖą░ąĮčéčŗ.

ą¤ąĄčĆąĄčģąŠą┤ ąĮą░ ąĮąŠą▓ąŠąĄ čüąĄčĆą▓ąĄčĆąĮąŠąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ ąĮąĄąĖąĘą▒ąĄąČąĮąŠ ą▓ą╗ąĄč湥čé ąĘą░ čüąŠą▒ąŠą╣ ą╝ą░čüčüčā ą┐čĆąŠą▒ą╗ąĄą╝ čü ąĖąĘą╝ąĄąĮąĄąĮąĖąĄą╝ ąĖąĮąČąĄąĮąĄčĆąĮąŠą╣ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ ą┤ą╗čÅ ą┐ąŠą▓čŗčłąĄąĮąĖčÅ čüč鹥ą┐ąĄąĮąĖ ąĄąĄ čāčéąĖą╗ąĖąĘą░čåąĖąĖ ŌĆō čüą▓ąŠą▒ąŠą┤ą░ ą┤ąĄą╣čüčéą▓ąĖą╣ ąĘą┤ąĄčüčī čćčĆąĄąĘą▓čŗčćą░ą╣ąĮąŠ ąŠą│čĆą░ąĮąĖč湥ąĮą░. ą£ąŠąČąĮąŠ ą┐ąŠą┐čŗčéą░čéčīčüčÅ ą┐ąŠą╝ąĄąĮčÅčéčī ą║ąŠąĮą┤ąĖčåąĖąŠąĮąĄčĆčŗ, ą▓ąĮąĄą┤čĆąĖčéčī ą║ą░ą║ąĖąĄ-č鹊 菹ĮąĄčĆą│ąŠčŹčäč乥ą║čéąĖą▓ąĮčŗąĄ čĆąĄčłąĄąĮąĖčÅ, ąĮąŠ čŹč鹊 ą┐čĆąĖą▓ąĄą┤ąĄčé ą║ ąĘąĮą░čćąĖč鹥ą╗čīąĮčŗą╝ ą┐čĆąŠčüč鹊čÅą╝. ąĢčüą╗ąĖ ą”ą×ąö ąŠą▒čüą╗čāąČąĖą▓ą░ąĄčé ąĮąĄčüą║ąŠą╗čīą║ąĖčģ ąĘą░ą║ą░ąĘčćąĖą║ąŠą▓ ąĖą╗ąĖ ą┤ą░ąČąĄ ąĮąĄčüą║ąŠą╗čīą║ąŠ ą▒ąĖąĘąĮąĄčü-ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣, ą║ą░ą║ąĖąĄ-ą╗ąĖą▒ąŠ ąĖąĘą╝ąĄąĮąĄąĮąĖčÅ ąĄą│ąŠ ąĖąĮąČąĄąĮąĄčĆąĮąŠą╣ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ, čüą▓čÅąĘą░ąĮąĮčŗąĄ čü ą┐čĆąŠčüč鹊čÅą╝ąĖ, ą┐ąŠą┐čĆąŠčüčéčā ąĮąĄą┐čĆąĖąĄą╝ą╗ąĄą╝čŗ. ąØąĄąŠą▒čģąŠą┤ąĖą╝ ą║ąŠą╝ą┐ą╗ąĄą║čüąĮčŗą╣ ą┐ąŠą┤čģąŠą┤, ąŠčģą▓ą░čéčŗą▓ą░čÄčēąĖą╣ ąĮąĄ č鹊ą╗čīą║ąŠ čüąĄčĆą▓ąĄčĆąĮčāčÄ, ąĮąŠ ąĖ ąĖąĮąČąĄąĮąĄčĆąĮčāčÄ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčā ą”ą×ąöą░.

ąöąŠ čüąĖčģ ą┐ąŠčĆ, ąŠą┤ąĮą░ą║ąŠ, ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗ąĖ ąĖąĮąČąĄąĮąĄčĆąĮąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ čéčĆą░ą┤ąĖčåąĖąŠąĮąĮąŠ ąĮąĄ ąŠčĆąĖąĄąĮčéąĖčĆčāčÄčéčüčÅ ąĮą░ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗ąĄą╣ čüąĄčĆą▓ąĄčĆąŠą▓, ąĖ ąĮą░ąŠą▒ąŠčĆąŠčé. ąÆąŠąŠą▒čēąĄ čüčĆąĄą┤ąĖ ą┐čĆąĄą┤čüčéą░ą▓ąĖč鹥ą╗ąĄą╣ "čģą░ą╣č鹥ą║ąŠą▓čüą║ąŠą│ąŠ ą╝ąĄą╣ąĮčüčéčĆąĖą╝ą░" ą║ąŠąĮą║čāčĆąĄąĮčåąĖčÅ čćčĆąĄąĘą▓čŗčćą░ą╣ąĮąŠ ą▓čŗčüąŠą║ą░, ąŠ ą║ą░ą║ąŠą╝-č鹊 ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖąĖ ąĖ čüąŠčéčĆčāą┤ąĮąĖč湥čüčéą▓ąĄ ą│ąŠą▓ąŠčĆąĖčéčī ąĘą┤ąĄčüčī ąĮąĄ ą┐čĆąĖčģąŠą┤ąĖčéčüčÅ. ąÆ čĆąĄąĘčāą╗čīčéą░č鹥 ą▓ąŠąĘąĮąĖą║ą░ąĄčé čéą░ čüą░ą╝ą░čÅ čäčĆą░ą│ą╝ąĄąĮčéą░čåąĖčÅ.

ąöą╗čÅ ą┤ąĄčäčĆą░ą│ą╝ąĄąĮčéą░čåąĖąĖ ą╝ąŠąČąĮąŠ ą┐ąŠą┐čŗčéą░čéčīčüčÅ ą┐čĆąĖą╝ąĄąĮąĖčéčī ąĖąĘą▓ąĄčüčéąĮčŗąĄ č鹥čģąĮąŠą╗ąŠą│ąĖč湥čüą║ąĖąĄ čĆąĄčłąĄąĮąĖčÅ. ą×ą┤ąĮąĖą╝ ąĖąĘ čéą░ą║ąĖčģ čĆąĄčłąĄąĮąĖą╣ čÅą▓ą╗čÅąĄčéčüčÅ ą¤ą× DCIM (Data Center Infrastructure Management ŌĆō čāą┐čĆą░ą▓ą╗ąĄąĮąĖąĄ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆąŠą╣ ą”ą×ąöą░). ąĪ ą┐ąŠą╝ąŠčēčīčÄ DCIM ą╝ąŠąČąĮąŠ, ąĮą░ą┐čĆąĖą╝ąĄčĆ, ą▓čŗčÅčüąĮąĖčéčī, ą│ą┤ąĄ ą▓ ą”ą×ąöąĄ ąĖą╝ąĄčÄčéčüčÅ ąŠą▒ą╗ą░čüčéąĖ čüą▓ąŠą▒ąŠą┤ąĮčŗčģ čĆąĄčüčāčĆčüąŠą▓, ąĖ, ąĮą░ąŠą▒ąŠčĆąŠčé, ą▓čŗčÅą▓ąĖčéčī ąŠčćą░ą│ąĖ ą┐ąĄčĆąĄą│čĆčāąĘą║ąĖ, ą▓čŗąĘčŗą▓ą░čÄčēąĖąĄ ą┐ąĄčĆąĄą│čĆąĄą▓ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ.

ąöčĆčāą│ąĖą╝ čĆąĄčłąĄąĮąĖąĄą╝ ą╝ąŠąČąĄčé čüą╗čāąČąĖčéčī ą▓ąĖčĆčéčāą░ą╗ąĖąĘą░čåąĖčÅ. ą×ąĮą░ ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ą┐ąŠą╗čāč湥ąĮąĮčāčÄ čü ą┐ąŠą╝ąŠčēčīčÄ DCIM ąĖąĮč乊čĆą╝ą░čåąĖčÄ ą┤ą╗čÅ č乊čĆą╝ąĖčĆąŠą▓ą░ąĮąĖčÅ čāą┐čĆą░ą▓ą╗čÅčÄčēąĖčģ čüąĖą│ąĮą░ą╗ąŠą▓ čü čåąĄą╗čīčÄ ą┐ąĄčĆąĄčĆą░čüą┐čĆąĄą┤ąĄą╗ąĄąĮąĖčÅ ą▓ąĖčĆčéčāą░ą╗ąĖąĘąĖčĆąŠą▓ą░ąĮąĮčŗčģ čĆąĄčüčāčĆčüąŠą▓ (ą▓ąĖčĆčéčāą░ą╗čīąĮčŗčģ ą╝ą░čłąĖąĮ). ąóą░ą║ąĖą╝ ąŠą▒čĆą░ąĘąŠą╝, ą╝ąŠąČąĮąŠ ą┐ąŠą┐čŗčéą░čéčīčüčÅ ą▓čŗčĆąŠą▓ąĮčÅčéčī ąĮą░ą│čĆčāąĘą║čā ąĮą░ čäąĖąĘąĖč湥čüą║čāčÄ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčā ą”ą×ąöą░.

ąæą╗ą░ą│ąŠą┤ą░čĆčÅ ą▓ąĖčĆčéčāą░ą╗ąĖąĘą░čåąĖąĖ ą┐ąŠčüč鹥ą┐ąĄąĮąĮąŠ čüą░ą╝ąĖ ą”ą×ąöčŗ, čü č鹊čćą║ąĖ ąĘčĆąĄąĮąĖčÅ ąĖčģ ąŠą┐ąĄčĆą░č鹊čĆąŠą▓, ą┐ąĄčĆąĄčüčéą░ąĮčāčé čÅą▓ą╗čÅčéčī čüąŠą▒ąŠą╣ čäąĖąĘąĖč湥čüą║ąĖąĄ čüčāčēąĮąŠčüčéąĖ. ąóą░ą║, ąĮąĄčüą║ąŠą╗čīą║ąŠ č鹥čĆčĆąĖč鹊čĆąĖą░ą╗čīąĮąŠ čĆą░čüą┐čĆąĄą┤ąĄą╗ąĄąĮąĮčŗčģ čäąĖąĘąĖč湥čüą║ąĖčģ ą”ą×ąöąŠą▓ ą╝ąŠąČąĮąŠ ąŠą▒čŖąĄą┤ąĖąĮąĖčéčī ą▓ ąĄą┤ąĖąĮčŗą╣ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╣ ą”ą×ąö čü ą▓ąĖčĆčéčāą░ą╗čīąĮąŠą╣ čüčĆąĄą┤ąŠą╣. ą¤čĆąĖ čŹč鹊ą╝ ą▓ ą║ą░č湥čüčéą▓ąĄ ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮąŠą│ąŠ ą▒ąŠąĮčāčüą░ ą┐ąŠčÅą▓ąĖčéčüčÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ą┐ąŠą▓čŗčüąĖčéčī ąŠą▒čēąĖą╣ čāčĆąŠą▓ąĄąĮčī ąĮą░ą┤ąĄąČąĮąŠčüčéąĖ ą┤ą░čéą░-čåąĄąĮčéčĆą░ ą┐čĆąŠą│čĆą░ą╝ą╝ąĮčŗą╝ čüą┐ąŠčüąŠą▒ąŠą╝, ą▓čŗčüčéčĆą░ąĖą▓ą░ąĄą╝ąŠą│ąŠ ąĮą░ ą▒ą░ąĘąĄ ą”ą×ąöąŠą▓ čü ą▒ąŠą╗ąĄąĄ ąĮąĖąĘą║ąĖą╝ąĖ TIER.

ąś ąŠą┐ąĄčĆą░č鹊čĆčŗ, ąĖ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĖ ą”ą×ąöąŠą▓ čüčéčĆąĄą╝čÅčéčüčÅ ą╝ąĖąĮąĖą╝ąĖąĘąĖčĆąŠą▓ą░čéčī čüą▓ąŠąĖ ąŠą┐ąĄčĆą░čåąĖąŠąĮąĮčŗąĄ ąĘą░čéčĆą░čéčŗ (菹║čüą┐ą╗čāą░čéą░čåąĖąŠąĮąĮčŗąĄ čĆą░čüčģąŠą┤čŗ). ąöą╗čÅ č湥ą│ąŠ ąĮčāąČąĮąŠ čüčéčĆąĄą╝ąĖčéčīčüčÅ ą┤ąĄą╗ą░čéčī čüą░ą╝ąĖą╝ ą║ą░ą║ ą╝ąŠąČąĮąŠ ą╝ąĄąĮčīčłąĄ, čé.ąĄ. ąĘą░čüčéą░ą▓ąĖčéčī čĆą░ą▒ąŠčéą░čéčī ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ, ą┤ąŠą▒ąĖčéčīčüčÅ č鹊ą│ąŠ, čćč鹊ą▒čŗ ąŠąĮ čüą░ą╝ čāą┐čĆą░ą▓ą╗čÅą╗ čüą▓ąŠąĖą╝ąĖ čĆąĄčüčāčĆčüą░ą╝ąĖ. ąŁč鹊 ąŠąĘąĮą░čćą░ąĄčé, čćč鹊 ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ čüąŠąĘą┤ą░čéčī ąĮą░ą▒ąŠčĆ ąĮąĄą║ąĖčģ čüčéą░ąĮą┤ą░čĆčéąĮčŗčģ čéąĖą┐ąĖąĘąĖčĆąŠą▓ą░ąĮąĮčŗčģ čĆąĄčłąĄąĮąĖą╣ ąĖ čāą╣čéąĖ ąŠčé čĆąĄą│čāą╗čÅčĆąĮąŠą│ąŠ "ąĖąĘąŠą▒čĆąĄč鹥ąĮąĖčÅ ą▓ąĄą╗ąŠčüąĖą┐ąĄą┤ą░", ąĖąĮą░č湥 ą│ąŠą▓ąŠčĆčÅ ŌĆō ą┐ąŠčüčéčĆąŠąĄąĮąĖčÅ ą║ą░ąČą┤čŗą╣ čĆą░ąĘ ąĮąŠą▓ąŠą╣ ąŠčüąŠą▒ąŠą╣ ą▓ąĖčĆčéčāą░ą╗čīąĮąŠą╣ čüčĆąĄą┤čŗ ą┤ą╗čÅ ąĘą░ą║ą░ąĘčćąĖą║ą░.

ą¤čĆąĄą┤ą┐ąŠą╗ąŠąČąĖą╝, ąĘą░ą║ą░ąĘčćąĖą║ čāčüą╗čāą│ ą”ą×ąö čģąŠč湥čé ą┐ąŠą╗čāčćąĖčéčī ą▓ čüą▓ąŠąĄ čĆą░čüą┐ąŠčĆčÅąČąĄąĮąĖąĄ ąĮąĄą║ąŠąĄ ą▓ąĖčĆčéčāą░ą╗čīąĮąŠąĄ ą┐čĆąŠčüčéčĆą░ąĮčüčéą▓ąŠ ą┤ą╗čÅ čüą▓ąŠąĖčģ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣. ą×ą┐ąĄčĆą░č鹊čĆ ą”ą×ąöą░, čüąŠ čüą▓ąŠąĄą╣ čüč鹊čĆąŠąĮčŗ, ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅąĄčé ąĘą░ą║ą░ąĘčćąĖą║čā ąĮą░ą▒ąŠčĆ čŹą╗ąĄą╝ąĄąĮč鹊ą▓ (čüą▓ąŠąĄą│ąŠ čĆąŠą┤ą░ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╣ ą║ąŠąĮčüčéčĆčāą║č鹊čĆ), ą┐ąŠąĘą▓ąŠą╗čÅčÄčēąĖą╣ č鹊ą╝čā čüą░ą╝ąŠčüč鹊čÅč鹥ą╗čīąĮąŠ čüąŠąĘą┤ą░čéčī čéą░ą║ąŠąĄ ą┐čĆąŠčüčéčĆą░ąĮčüčéą▓ąŠ. ąöąŠą┐čāčüčéąĖą╝, ąĘą░ą║ą░ąĘčćąĖą║čā ąĮčāąČąĮčŗ ą▓čŗą┤ąĄą╗ąĄąĮąĮą░čÅ čüąĄčéčī, čüąŠą▒čüčéą▓ąĄąĮąĮčŗąĄ ą╝ą░čĆčłčĆčāčéąĖąĘą░č鹊čĆ, ą╝ąĄąČčüąĄč鹥ą▓ąŠą╣ 菹║čĆą░ąĮ, ą║ąŠą╝ą╝čāčéą░č鹊čĆ ąĖ čé.ą┤. ą¤čĆąĄąČą┤ąĄ čŹč鹊 ą▓čüąĄ ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅą╗ąŠčüčī ąĄą╝čā (ąĘą░ ą┤ąŠą▓ąŠą╗čīąĮąŠ ą▒ąŠą╗čīčłąĖąĄ ą┤ąĄąĮčīą│ąĖ) ąŠą┐ąĄčĆą░č鹊čĆąŠą╝ ą▓ ą▓ąĖą┤ąĄ čäąĖąĘąĖč湥čüą║ąĖčģ ą╗ąĖąĮąĖą╣ čüą▓čÅąĘąĖ ąĖ čüąĄč鹥ą▓čŗčģ čāčüčéčĆąŠą╣čüčéą▓.

ąÆąĖčĆčéčāą░ą╗ąĖąĘą░čåąĖčÅ ą┐čĆąĖą▓ąĄą╗ą░ ą║ č鹊ą╝čā, čćč鹊 čüąĄą│ąŠą┤ąĮčÅ ą┐čĆą░ą║čéąĖč湥čüą║ąĖ ą▓čüąĄ čüąŠčüčéą░ą▓ą╗čÅčÄčēąĖąĄ ą║ąŠčĆą┐ąŠčĆą░čéąĖą▓ąĮąŠą╣ čüąĄčéąĖ ą╝ąŠąČąĮąŠ ąĘą░ą╝ąĄąĮąĖčéčī čüąŠąŠčéą▓ąĄčéčüčéą▓čāčÄčēąĖą╝ąĖ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╝ąĖ čāčüčéčĆąŠą╣čüčéą▓ą░ą╝ąĖ: čäąĖąĘąĖč湥čüą║ąĖą╣ čüąĄčĆą▓ąĄčĆ ŌĆō ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╝ čüąĄčĆą▓ąĄčĆąŠą╝, čäąĖąĘąĖč湥čüą║ąĖą╣ ą╝ą░čĆčłčĆčāčéąĖąĘą░č鹊čĆ ŌĆō ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╝ ą╝ą░čĆčłčĆčāčéąĖąĘą░č鹊čĆąŠą╝ ąĖ čé.ą┤. ąÆčüąĄ čŹč鹊 čüčāčēąĄčüčéą▓čāąĄčé ą▓ ą▓ąĖčĆčéčāą░ą╗čīąĮąŠą╣ čüčĆąĄą┤ąĄ, čĆą░ąĘą▓ąĄčĆąĮčāč鹊ą╣ ą┐ąŠą▓ąĄčĆčģ ąŠą┤ąĮąŠčéąĖą┐ąĮčŗčģ čüčéą░ąĮą┤ą░čĆčéąĖąĘąĖčĆąŠą▓ą░ąĮąĮčŗčģ 菹║ąŠąĮąŠą╝ąĖčćąĮčŗčģ čüąĄčĆą▓ąĄčĆąŠą▓. ąÜą░ąČą┤ąŠąĄ ą▓ąĖčĆčéčāą░ą╗čīąĮąŠąĄ čāčüčéčĆąŠą╣čüčéą▓ąŠ ą╝ąŠąČąĮąŠ čĆąĄąĘąĄčĆą▓ąĖčĆąŠą▓ą░čéčī ą╝ąĄč鹊ą┤ąŠą╝ ą┐čĆąŠčüč鹊ą│ąŠ ą║ąŠą┐ąĖčĆąŠą▓ą░ąĮąĖčÅ, ą░ ąĘą░č鹥ą╝ ą┐čĆąĖ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéąĖ ą▓ąŠčüčüčéą░ąĮą░ą▓ą╗ąĖą▓ą░čéčī ąĖąĘ čĆąĄąĘąĄčĆą▓ąĮąŠą╣ ą║ąŠą┐ąĖąĖ. ąóąĖčĆą░ąČąĖčĆąŠą▓ą░čéčī ą▓ąĖčĆčéčāą░ą╗čīąĮčŗąĄ čāčüčéčĆąŠą╣čüčéą▓ą░ ą╝ąĄč鹊ą┤ąŠą╝ ą║ąŠą┐ąĖčĆąŠą▓ą░ąĮąĖčÅ čéą░ą║ąČąĄ čćčĆąĄąĘą▓čŗčćą░ą╣ąĮąŠ ą╗ąĄą│ą║ąŠ. ąŁč鹊 ąŠčéąĮąŠčüąĖčéčüčÅ ą║ąŠ ą▓čüąĄą╝ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╝ čāčüčéčĆąŠą╣čüčéą▓ą░ą╝. ą¤ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÄ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗąĄ čāčüčéčĆąŠą╣čüčéą▓ą░ ąŠą▒čģąŠą┤čÅčéčüčÅ ą┤ąĄčłąĄą▓ą╗ąĄ ą░ą┐ą┐ą░čĆą░čéąĮčŗčģ, ą░ ąŠą┐ąĄčĆą░č鹊čĆčā ąĮąĄčé ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéąĖ ąĮąĖ ą┐čĆąĖąŠą▒čĆąĄčéą░čéčī ąĖ 菹║čüą┐ą╗čāą░čéąĖčĆąŠą▓ą░čéčī čüą┐ąĄčåąĖą░ą╗ąĖąĘąĖčĆąŠą▓ą░ąĮąĮąŠąĄ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖąĄ, ąĮąĖ ą▓čŗą┤ąĄą╗čÅčéčī ą┤ą╗čÅ čŹč鹊ą│ąŠ ą║ą▓ą░ą╗ąĖčäąĖčåąĖčĆąŠą▓ą░ąĮąĮčŗą╣ ą┐ąĄčĆčüąŠąĮą░ą╗ ąĖ ąŠą▒ąĄčüą┐ąĄčćąĖą▓ą░čéčī ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčāčÄ ąŠčéą║ą░ąĘąŠčāčüč鹊ą╣čćąĖą▓ąŠčüčéčī, č鹥ą╝ čüą░ą╝čŗą╝ ąŠą┐ąĄčĆą░čåąĖąŠąĮąĮčŗąĄ ąĘą░čéčĆą░čéčŗ ąŠą┐ąĄčĆą░č鹊čĆą░ ą”ą×ąöą░ čüąŠą║čĆą░čēą░čÄčéčüčÅ.

ąóą░ą║ąĖąĄ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗąĄ čüčāčēąĮąŠčüčéąĖ ą╝ąŠąČąĮąŠ ą┐čĆąĄą┤čüčéą░ą▓ąĖčéčī ą▓ ą▓ąĖą┤ąĄ ą┤čĆčāąČąĄčüčéą▓ąĄąĮąĮąŠą│ąŠ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÄ ąĖąĮč鹥čĆč乥ą╣čüą░ (ą▓ č鹊ą╝ čćąĖčüą╗ąĄ ąĖ Web-), ą▓ ą║ąŠč鹊čĆąŠą╝ ą▓čüąĄ ąŠą┐ąĄčĆą░čåąĖąĖ ąĖ ąŠą▒čŖąĄą╝čŗ ą┐ąŠčéčĆąĄą▒ą╗ąĄąĮąĖčÅ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗčģ čĆąĄčüčāčĆčüąŠą▓ ą╝ąŠą│čāčé ą▒čŗčéčī ą┐čĆąŠąĘčĆą░čćąĮąŠ čéą░čĆąĖčäąĖčåąĖčĆąŠą▓ą░ąĮčŗ. ą¤ąŠą╗čīąĘčāčÅčüčī čŹčéąĖą╝ ąĖąĮč鹥čĆč乥ą╣čüąŠą╝, ąĘą░ą║ą░ąĘčćąĖą║ čüą░ą╝ čüąŠą▒ąĖčĆą░ąĄčé ąĮčāąČąĮąŠąĄ ąĄą╝čā čĆąĄčłąĄąĮąĖąĄ, ąĮąĄ ą┐čĆąĖąŠą▒čĆąĄčéą░čÅ ą┐čĆąĖ čŹč鹊ą╝ ąĮąĖ ą▓ ą░čĆąĄąĮą┤čā, ąĮąĖ ą▓ čüąŠą▒čüčéą▓ąĄąĮąĮąŠčüčéčī ąĮąĖą║ą░ą║ąŠą│ąŠ čäąĖąĘąĖč湥čüą║ąŠą│ąŠ ąŠą▒ąŠčĆčāą┤ąŠą▓ą░ąĮąĖčÅ. ąĪą▓ąŠąĖ ą▒ąĖąĘąĮąĄčü-ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ ąŠąĮ čĆą░ąĘą▓ąĄčĆąĮąĄčé ą▓ ą▓ąĖčĆčéčāą░ą╗čīąĮąŠą╣ čüčĆąĄą┤ąĄ, ą║ąŠč鹊čĆčāčÄ čüą░ą╝ ąČąĄ ą┤ą╗čÅ čüąĄą▒čÅ čüąŠąĘą┤ą░ą╗. ą×ą┐ąĄčĆą░č鹊čĆ ą”ą×ąöą░, čüąŠ čüą▓ąŠąĄą╣ čüč鹊čĆąŠąĮčŗ, ąĮąĄ ąĘą░čéčĆą░čćąĖą▓ą░ąĄčé ąĮą░ čŹč鹊 ąĮąĖ ąŠą┤ąĮąŠą│ąŠ č湥ą╗ąŠą▓ąĄą║ąŠ-čćą░čüą░, ą┐ąŠčüą║ąŠą╗čīą║čā ą▓čüąĄ ąĮąĄąŠą▒čģąŠą┤ąĖą╝čŗąĄ ą┤ąĄą╣čüčéą▓ąĖčÅ ą▓čŗą┐ąŠą╗ąĮčÅąĄčé čüą░ą╝ ąĘą░ą║ą░ąĘčćąĖą║ ŌĆō čüąŠąĘą┤ą░ąĄčé ą▓ąĖčĆčéčāą░ą╗čīąĮčāčÄ čüąĄčéčī, čģčĆą░ąĮąĖą╗ąĖčēąĄ, čüąĄčĆą▓ąĄčĆčŗ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ ąĖ čé.ą┤.

ą¤ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĖ ąĮąĄ čüą║ą╗ąŠąĮąĮčŗ ą║ č鹊ą╝čā, čćč鹊ą▒čŗ ą┐ą╗ą░čéąĖčéčī ą▓ą┐ąĄčĆąĄą┤, ąĄčüą╗ąĖ ąĮą░ č鹥ą║čāčēąĖą╣ ą╝ąŠą╝ąĄąĮčé ąĮąĄ ąĖčüą┐čŗčéčŗą▓ą░čÄčé ą┐ąŠčéčĆąĄą▒ąĮąŠčüčéąĖ ą▓ č鹊ą╝ ąĖą╗ąĖ ąĖąĮąŠą╝ čĆąĄčüčāčĆčüąĄ. ąØą░ą┐čĆąĖą╝ąĄčĆ, ąĮą░ ąĮą░čćą░ą╗čīąĮąŠą╣ čüčéą░ą┤ąĖąĖ čĆą░ą▒ąŠčéčŗ ą╝ąŠąČąĮąŠ ąŠą│čĆą░ąĮąĖčćąĖčéčīčüčÅ ą╝ąĖąĮąĖą╝ą░ą╗čīąĮčŗą╝ ą║ąŠą╗ąĖč湥čüčéą▓ąŠą╝ ą┐ąŠčĆč鹊ą▓ ąĮą░ ą╝ą░čĆčłčĆčāčéąĖąĘą░č鹊čĆąĄ ąĖ ą╗ąĖčłčī ą┐čĆąĖ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéąĖ ą▓ą┐ąŠčüą╗ąĄą┤čüčéą▓ąĖąĖ ą┐čĆąĖąŠą▒čĆąĄčüčéąĖ ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčŗąĄ ą┐ąŠčĆčéčŗ (čĆą░ąĘčāą╝ąĄąĄčéčüčÅ, ą▓ąĖčĆčéčāą░ą╗čīąĮčŗąĄ). ą£ą░čüčłčéą░ą▒ąĖčĆąŠą▓ą░ąĮąĖąĄ čĆąĄčłąĄąĮąĖčÅ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĖ čüąŠ ąĘąĮą░ą║ąŠą╝ ą╝ąĖąĮčāčü: čüčéą░ą▓čłąĖąĄ ąĮąĄąĮčāąČąĮčŗą╝ąĖ ą┐ąŠčĆčéčŗ ą╝ąŠąČąĮąŠ ąĖčüą║ą╗čÄčćąĖčéčī ąĖąĘ čĆąĄčłąĄąĮąĖčÅ ąĖ ą┐ąĄčĆąĄčüčéą░čéčī ą┐ą╗ą░čéąĖčéčī ąĘą░ ąĮąĖčģ. ąÆ ą┐čĆąĄąČąĮąĖąĄ ą▓čĆąĄą╝ąĄąĮą░ ą┐ąŠčüą╗ąĄą┤ąĮąĄąĄ ą┐čĆąĄą┤čüčéą░ą▓ą╗čÅą╗ąŠ ą▒ąŠą╗čīčłčāčÄ ą┐čĆąŠą▒ą╗ąĄą╝čā, ą▓ąĄą┤čī čäąĖąĘąĖč湥čüą║ąĖąĄ ą┐ąŠčĆčéčŗ čāą┤ą░ą╗ąĖčéčī ąĮąĄ čéą░ą║ ą┐čĆąŠčüč鹊, ą║ą░ą║ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗąĄ.

ąĪąĄą│ąŠą┤ąĮčÅ ą”ą×ąöčŗ čüčéą░ąĮąŠą▓čÅčéčüčÅ ą│ąĖą▒č湥, ąĖ ąŠą┐ą╗ą░čéčā ąĖčģ čāčüą╗čāą│ ąĘą░ą║ą░ąĘčćąĖą║ąĖ ą╝ąŠą│čāčé ąŠą┐čéąĖą╝ąĖąĘąĖčĆąŠą▓ą░čéčī ą┐ąŠ čüą▓ąŠąĄą╝čā čāčüą╝ąŠčéčĆąĄąĮąĖčÄ, ąĮąĄ "ąĘą░ą╝ąŠčĆą░ąČąĖą▓ą░čÅ" čüą▓ąŠąĖ ą┤ąĄąĮčīą│ąĖ. ąóą░ą║ąŠą▓ą░ ąŠą▒čēą░čÅ č鹥ąĮą┤ąĄąĮčåąĖčÅ, ąĖ ąŠąĮą░ ąĮą░ą▒ąĖčĆą░ąĄčé ąŠą▒ąŠčĆąŠčéčŗ.

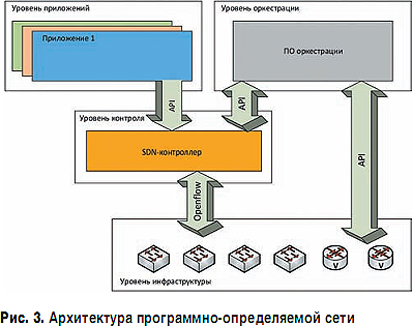

ąĢčüą╗ąĖ ą┤ąŠ 2010 ą│. ąŠą┐ąĄčĆą░č鹊čĆčŗ ą”ą×ąöąŠą▓ čāčćąĖą╗ąĖčüčī čāą┐čĆą░ą▓ą╗čÅčéčī ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╝ąĖ ą╝ą░čłąĖąĮą░ą╝ąĖ, č鹊 ąĮą░čćąĖąĮą░čÅ čü 2011ŌĆō2012 ą│ą│. ą░ą║čéčāą░ą╗čīąĮąŠčüčéčī ą┐čĆąĖąŠą▒čĆąĄą╗ą░ ą▓ąĖčĆčéčāą░ą╗ąĖąĘą░čåąĖčÅ čüąĄč鹥ą╣ ą┐ąŠčüčĆąĄą┤čüčéą▓ąŠą╝ č鹥čģąĮąŠą╗ąŠą│ąĖą╣ SDN (ą┐čĆąŠą│čĆą░ą╝ą╝ąĮąŠ-ąŠą┐čĆąĄą┤ąĄą╗čÅąĄą╝čŗąĄ čüąĄčéąĖ), NFV ąĖ ąĖą╝ ą┐ąŠą┤ąŠą▒ąĮčŗčģ. ąöąĄą╗ąŠ ą▓ č鹊ą╝, čćč鹊 ą║ą░ąČą┤ąŠą╣ čüąŠąĘą┤ą░ąĮąĮąŠą╣ ą▓ čĆą░ą╝ą║ą░čģ ą▓ąĖčĆčéčāą░ą╗ąĖčĆąĖčĆąŠą▓ą░ąĮąĮąŠą│ąŠ ą”ą×ąöą░ ą║ąŠčĆą┐ąŠčĆą░čéąĖą▓ąĮąŠą╣ čüąĄčéąĖ ąĮąĄą║ąŠąĄą│ąŠ ąĘą░ą║ą░ąĘčćąĖą║ą░ ą┐čĆąĖčüčāčēą░ čāąĮąĖą║ą░ą╗čīąĮą░čÅ čüčģąĄą╝ą░ čĆą░čüą┐čĆąĄą┤ąĄą╗ąĄąĮąĖčÅ IP-ą░ą┤čĆąĄčüąŠą▓, ą║ ą║ąŠč鹊čĆčŗą╝ ąČąĄčüčéą║ąŠ ą┐čĆąĖą▓čÅąĘą░ąĮčŗ čäčāąĮą║čåąĖąŠąĮąĖčĆčāčÄčēąĖąĄ ą▓ čéą░ą║ąŠą╣ čüąĄčéąĖ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ. ąÆąĖčĆčéčāą░ą╗ąĖąĘą░čåąĖčÅ čüąĄčéąĖ, ą▒čāą┤čāčćąĖ čüčéą░ąĮą┤ą░čĆčéąĖąĘąĖčĆąŠą▓ą░ąĮąĮąŠą╣, ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ą┐ąĄčĆąĄąĮąŠčüąĖčéčī ąĄąĄ ąĖąĘ ąŠą┤ąĮąŠą│ąŠ ą”ą×ąöą░ ą▓ ą┤čĆčāą│ąŠą╣, ąĮąĄ ą╝ąĄąĮčÅčÅ ą┐čĆąĖ čŹč鹊ą╝ IP-ą░ą┤čĆąĄčüą░čåąĖčÄ, čéą░ą║ ąČąĄ ą╗ąĄą│ą║ąŠ, ą║ą░ą║ ąŠčéą┤ąĄą╗čīąĮąŠ ą▓ąĘčÅčéčāčÄ ą▓ąĖčĆčéčāą░ą╗čīąĮčāčÄ ą╝ą░čłąĖąĮčā.

ąÆą░ąČąĮčŗą╝ ą░čüą┐ąĄą║č鹊ą╝ ą┤ą╗čÅ ą▓ąŠąĘą╝ąŠąČąĮąŠą│ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗčģ ą”ą×ąöąŠą▓, ąŠą▒ą╗ą░čćąĮčŗčģ čāčüą╗čāą│ ą┤ą╗čÅ ą║ąŠčĆą┐ąŠčĆą░čéąĖą▓ąĮčŗčģ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĄą╣ čÅą▓ą╗čÅąĄčéčüčÅ ą┤ąŠą▓ąĄčĆąĖąĄ. ąÜ čüąŠąČą░ą╗ąĄąĮąĖčÄ, ą▓ ąĀąŠčüčüąĖąĖ ą▓ ą┤ą░ąĮąĮąŠą╝ ąŠčéąĮąŠčłąĄąĮąĖąĖ ą║čāą╗čīčéčāčĆą░ ą▒ąĖąĘąĮąĄčüą░ ąĮą░čģąŠą┤ąĖčéčüčÅ ąĮą░ ą▓ąĄčüčīą╝ą░ ąĮąĖąĘą║ąŠą╝ čāčĆąŠą▓ąĮąĄ. ąÆčüąĄ čüą╗ąŠą▓ąĮąŠ ąČą┤čāčé ą║ą░ą║ąŠą│ąŠ-ąĮąĖą▒čāą┤čī ą┐ąŠą┤ą▓ąŠčģą░ čü čćčīąĄą╣-ą╗ąĖą▒ąŠ čüč鹊čĆąŠąĮčŗ. ą¤ąŠčŹč鹊ą╝čā, ą▓ čćą░čüčéąĮąŠčüčéąĖ, ą║čĆčāą┐ąĮąĄą╣čłąĖąĄ čĆąŠčüčüąĖą╣čüą║ąĖąĄ ą┐čĆąĄą┤ą┐čĆąĖčÅčéąĖčÅ ąĮąĄ čüą┐ąĄčłą░čé ą┐ąĄčĆąĄą▓ąŠą┤ąĖčéčī čüą▓ąŠąĖ ą▒ąĖąĘąĮąĄčü-ą║čĆąĖčéąĖč湥čüą║ąĖąĄ čüąĖčüč鹥ą╝čŗ ą▓ čćčīąĄ-ą╗ąĖą▒ąŠ ąŠą▒ą╗ą░ą║ąŠ, ąĮąĄ ąĖą╝ąĄčÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ą║ąŠąĮčéčĆąŠą╗ąĖčĆąŠą▓ą░čéčī ąĄą│ąŠ čäąĖąĮą░ąĮčüąŠą▓čŗą╝ąĖ, ą░ą┤ą╝ąĖąĮąĖčüčéčĆą░čéąĖą▓ąĮčŗą╝ąĖ ąĖą╗ąĖ ąĖąĮčŗą╝ąĖ ą╝ąĄč鹊ą┤ą░ą╝ąĖ.

ąóąĄą╝ ąĮąĄ ą╝ąĄąĮąĄąĄ, ą┤ą▓ąĖąČąĄąĮąĖąĄ ą▓ čüč鹊čĆąŠąĮčā ą▓ąĖčĆčéčāą░ą╗ąĖąĘą░čåąĖąĖ ą”ą×ąöąŠą▓ ąĮą░ą▒ąĖčĆą░ąĄčé čüą║ąŠčĆąŠčüčéčī. ą×ą┤ąĮą░ ąĖąĘ ą▓ą░ąČąĮčŗčģ ą┐čĆąĖčćąĖąĮ č鹊ą╝čā ąĘą░ą║ą╗čÄčćą░ąĄčéčüčÅ, ą▓ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ŌĆō čüąĮąŠą▓ą░, ą║ą░ąĘą░ą╗ąŠčüčī ą▒čŗ, ą┐ą░čĆą░ą┤ąŠą║čüą░ą╗čīąĮąŠą╣ ŌĆō ą┐ąŠčüčéčĆąŠąĖčéčī ą▓čŗčüąŠą║ąŠąĮą░ą┤ąĄąČąĮčŗą╣ ą▓ąĖčĆčéčāą░ą╗čīąĮčŗą╣ ą”ą×ąö ąĮą░ ąŠčüąĮąŠą▓ąĄ čäąĖąĘąĖč湥čüą║ąĖčģ ą”ą×ąöąŠą▓ čüčĆą░ą▓ąĮąĖč鹥ą╗čīąĮąŠ ą▒ąŠą╗ąĄąĄ ąĮąĖąĘą║ąŠą╣ čüč鹥ą┐ąĄąĮąĖ ąĮą░ą┤ąĄąČąĮąŠčüčéąĖ. ąŚą┤ąĄčüčī ą▒čŗą╗ą░ ą▒čŗ čāą╝ąĄčüčéąĮą░ ą░ąĮą░ą╗ąŠą│ąĖčÅ čü ąśąĮč鹥čĆąĮąĄč鹊ą╝, ą▓ ą║ąŠč鹊čĆąŠą╝ ą╗čÄą▒ąŠą╣ čäąĖąĘąĖč湥čüą║ąĖą╣ čāąĘąĄą╗ ąĖą╗ąĖ ą║ą░ąĮą░ą╗ čüą▓čÅąĘąĖ ą┐ąŠ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĖčÄ ąĮąĄąĮą░ą┤ąĄąČąĄąĮ.

ąøąĖč鹥čĆą░čéčāčĆą░

ą×ą┐čāą▒ą╗ąĖą║ąŠą▓ą░ąĮąŠ: ą¢čāčĆąĮą░ą╗ "ąóąĄčģąĮąŠą╗ąŠą│ąĖąĖ ąĖ čüčĆąĄą┤čüčéą▓ą░ čüą▓čÅąĘąĖ" #2, 2015

ą¤ąŠčüąĄčēąĄąĮąĖą╣: 7207

ąÉą▓č鹊čĆ

| |||

ąÆ čĆčāą▒čĆąĖą║čā "ą”ąĄąĮčéčĆčŗ ąŠą▒čĆą░ą▒ąŠčéą║ąĖ ą┤ą░ąĮąĮčŗčģ (ą”ą×ąö)" | ąÜ čüą┐ąĖčüą║čā čĆčāą▒čĆąĖą║ | ąÜ čüą┐ąĖčüą║čā ą░ą▓č鹊čĆąŠą▓ | ąÜ čüą┐ąĖčüą║čā ą┐čāą▒ą╗ąĖą║ą░čåąĖą╣